Médiapart a publié sur son site un pré-rapport d'une étude commandée par l'ADEME sur la faisabilité d'une production d'électricité totalement renouvelable en France. Par la suite, devant cette fuite, l'ADEME n'a guère eu d'autre choix que de publier elle-même ce document provisoire sur son site web. Ce post concerne le contenu de ce document, et il fait suite à celui concernant d'autres scénarios de production électrique 100% renouvelable (ou quasiment).

Comme explique dans le post précédent, le scénario de l'ADEME peut s'appuyer sur des précédents et ne sort pas de nulle part. En fait, pour faire le scénario le plus crédible possible, on peut déduire de ces précédents les choses suivantes:

- L'éolien terrestre va constituer la première source d'électricité. La production est répartie tout au long de l'année avec en moyenne un surplus en hiver, ce qui ressemble à la consommation. De plus, c'est aujourd'hui la source renouvelable d'électricité la moins chère aujourd'hui; les baisses de prix à prévoir pour en faire l'acteur dominant peuvent se révéler faibles. La France bénéficie aussi d'une situation relativement favorable du point de vue de l'intermittence avec une forte différenciation entre les régimes de vent au sud (Mistral et Tramontane) et au nord (vents d'Ouest venant de l'Atlantique). En supposant une amélioration de la technologie, le facteur de charge — la quantité produite rapporté au maximum possible — augmente à conditions météorologiques constantes, ce qui limite les besoins de stockage ou de lignes THT.

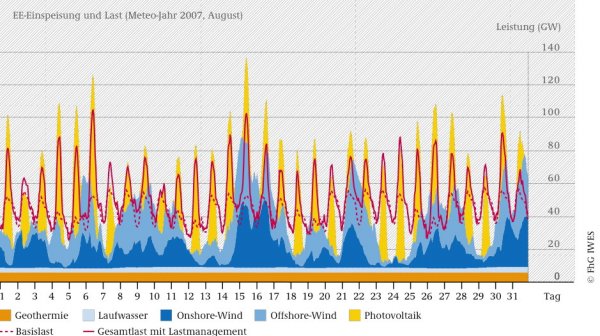

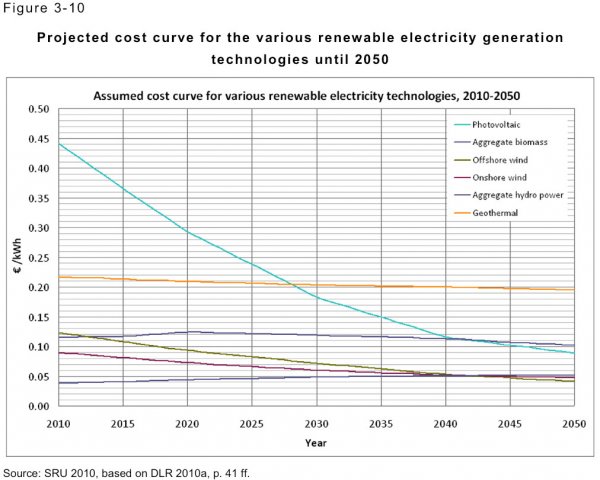

- Comme l'éolien ne suffit pas à lui tout seul, il faut lui adjoindre une autre source: en général, le photovoltaïque est indiqué car on peut en installer un peu partout, sur les toits dans le pire des cas. Comme une baisse des prix importante s'est produite ces dernières années, il suffit de prolonger la tendance pour obtenir des prix bas. Cependant, le photovoltaïque et l'énergie solaire en général présentent 2 gros défauts: la production est concentrée l'été et en milieu de journée ce qui provoque des pics de production.

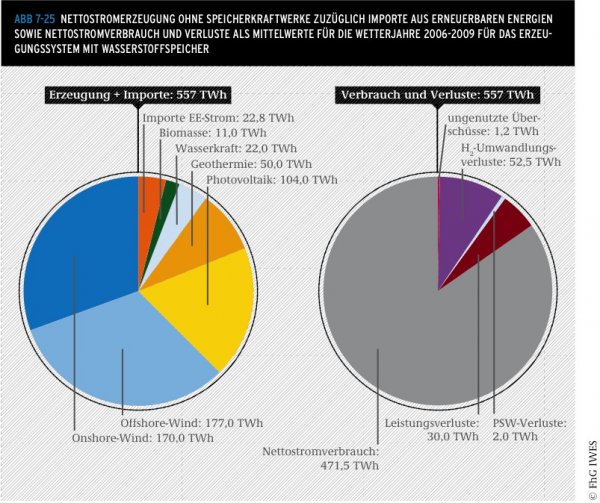

- En conséquence, il va falloir mobiliser de la demande mobile au cours de la journée ou de la semaine. En invoquant un mix de smart grid, de chauffage électrique et de voitures électriques, comme dans le scénario du Fraunhofer Institut, c'est réalisable. Il faut cependant rester à des puissances déplaçables raisonnables sous peine de paraître peu crédible.

- Pour compléter la gestion dynamique de la demande, il faudra du stockage. En effet, il est impossible de s'affranchir totalement de l'intermittence rien qu'avec le solaire et l'éolien: pour passer les périodes sans vent ni soleil, il faudrait construire énormément plus de capacités de production que l'énergie totale consommée ne le nécessite. Il faut aussi limiter cette composante, car cela coûte cher, tant en production qu'en argent. De ce côté, la France présente un atout avec ses lacs de barrage qui permettent de limiter cet appel au stockage.

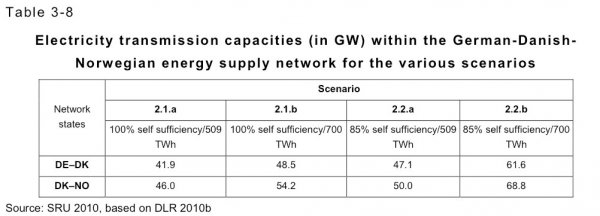

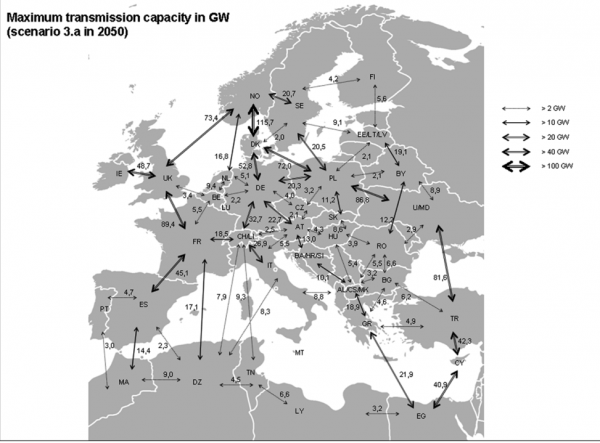

- Construire des lignes THT et se reposer sur le commerce international est aussi utile: c'est une façon relativement économique d'éponger les surplus et de remplir les creux. Une nouvelle fois, une minimisation des besoins est importante, non pas tant à cause des coûts que de l'opposition générale que la construction de ces lignes suscite

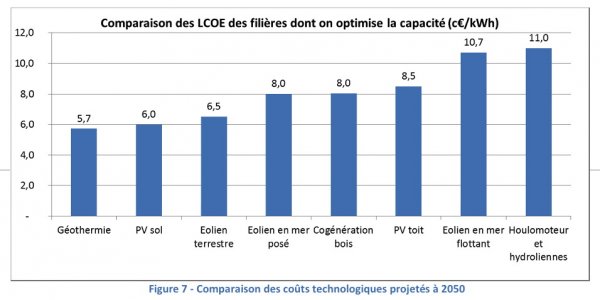

- Enfin, évidemment, il faut que les coûts des technologies favorisées soient présentés comme plutôt faibles, sinon le scénario ne semblerait pas très intéressant.

Le scénario de référence

Pour sélectionner la répartition entre technologies ainsi que la répartition spatiale des installations, un logiciel d'optimisation est utilisé pour minimiser les coûts totaux avec en entrée les coûts de chaque technologie par région ainsi que les coûts des lignes THT à installer. Les puissances à installer sont calculées région par région, les réseau THT est optimisé en minimisant les liens entre régions. Les conditions aux bornes sont que la situation commerciale de la France est neutre — autant d'imports que d'exports sur l'année — avec une capacité d'import-export fixée à l'avance au niveau actuel, que le stockage est équilibré sur l'année — autant d'entrées que de sorties — et que la consommation totale annuelle est de 422TWh.

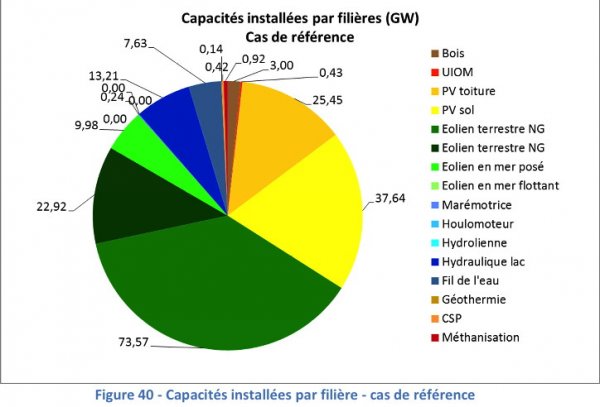

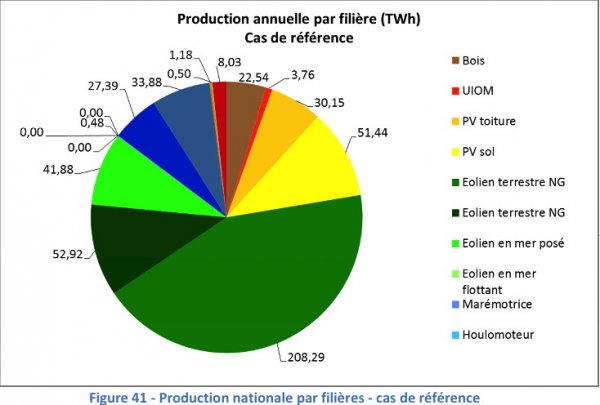

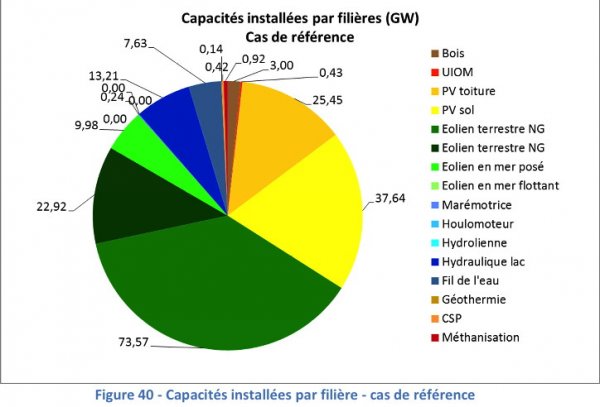

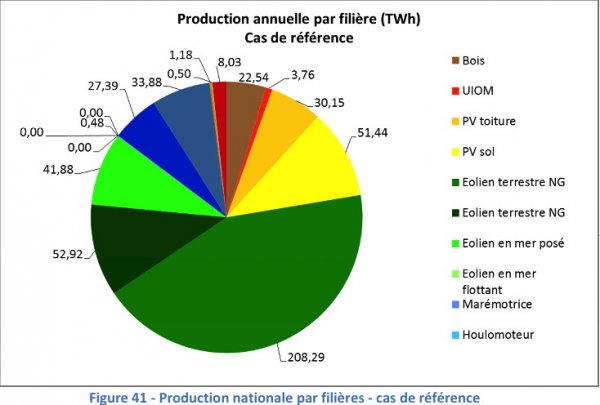

Pour couvrir cela dans le scénario de référence, environ 106GW d'éolien et 63GW de solaire PV sont installés pour compléter les installations hydro-électriques déjà présentes aujourd'hui, 3 GW de bois ainsi que diverses technologies plus ou moins obligatoires à présenter (solaire à concentration, géothermie, ordures ménagères …) mais qui n'ont aucun impact substantiel sur le résultat de la simulation. Le réseau THT modélisé a une capacité de 68GW, une augmentation a priori raisonnable de 30% par rapport à ce qui serait nécessaire aujourd'hui selon le même modèle. Le stockage est représenté par les 7GW de stations de pompage — plus ou moins ce qui existe déjà en France —, 12GW nouveaux de stockage court terme ainsi que 17GW de stockage long terme sous forme de méthane pour servir l'hiver. On peut voir la répartition complète pour les moyens de production «primaires» ci-dessous, ainsi que la répartition de la production qui en découle.

Comme on peut le voir, l'éolien sous ses diverses formes représente l'essentiel de la production primaire avec environ les 2/3 du total, l'éolien terrestre en assurant plus de la moitié à lui seul. Le solaire PV et l'hydraulique se partagent quasiment le reste à part presque égales avec une petite place pour les autres technologies. L'importance de l'hydraulique permet à ce scénario de partir sur des bases plus sympathiques que ceux étudiant l'Allemagne: avec les autres technologies renouvelables plus ou moins pilotables ou fonctionnant de façon continue, presque 25% de la demande est couverte. L'importance du stockage n'apparaît pas sur ces graphes — dommage! Mais la façon de le gérer est la principale innovation, me semble-t-il, de cette étude et ce qui permet de la rendre réaliste. En effet, les études passées en revue dans le post précédent achoppent sur deux points: s'il n'y a qu'un seul moyen de stockage adaptable, la puissance installée augmente fortement pour aller chercher l'ensemble du surplus dans les heures de forte production intermittente. En conséquence, le facteur de charge finit par baisser de façon dramatique ce qui fait exploser les coûts: une bonne partie des installations est de fait à l'arrêt toute l'année ou presque. Si on ne met pas de stockage, on doit alors utiliser du réseau à foison, ce qui finit par devenir irréaliste à cause de l'impopularité des lignes THT.

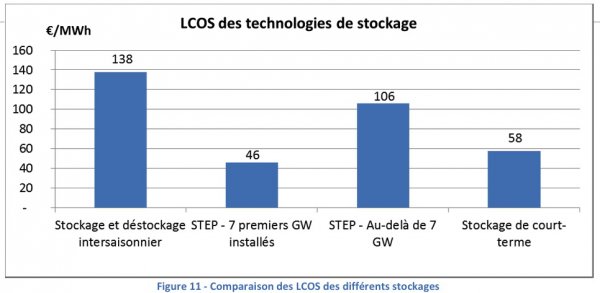

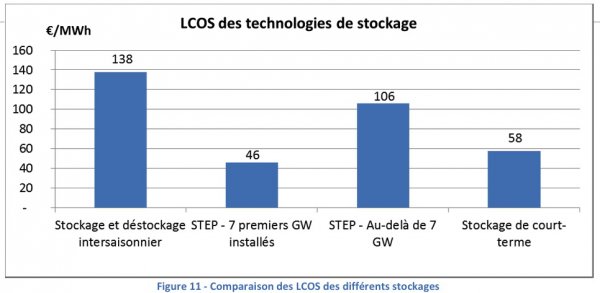

Le stockage est réparti en 3 classes: le court terme, le moyen terme (pompage) et le long terme (méthane). Un des points les plus importants est que le stockage de long terme coûte plus cher que les autres et il faut absolument en minimiser la puissance installée. De même pour les autres, même s'ils sont modélisés avec un coût nettement plus faible, les faire tourner le plus possible minimise les coûts totaux. Pour minimiser la puissance installée de l'entrée et de la sortie en stockage de long terme, l'étude autorise largement le recours aux transvasements entre stockages ainsi que le recours aux importations, même pour le remplissage (cf par exemple les figures 53 et 54 p44). On peut dire que c'est un succès: le facteur de charge de la transformation électricité vers gaz est d'environ 40% avec des mois où elle tourne en permanence comme le mois de juin (cf figure 72 p67) et pour le mois de février, c'est la sortie qui fonctionne à plein régime tout le mois. La flexibilité du stockage associé à son coût raisonnable est à mon avis ce qui explique, avec la proximité des coûts des technologies utilisées, le tir groupé sur les coûts qu'on constate dans l'étude. Cette façon de gérer le stockage permet aussi de limiter la gestion de la demande à une dizaine de GW. Associé aux 30GW de stockage, ça permet d'absorber l'ensemble des à-coups tout en restant dans une zone qui semble à peu près réaliste: c'est la première étude 100% renouvelable que je lis qui entre dans cette catégorie.

Le scénario de référence est complété par des variantes ou des concurrents:

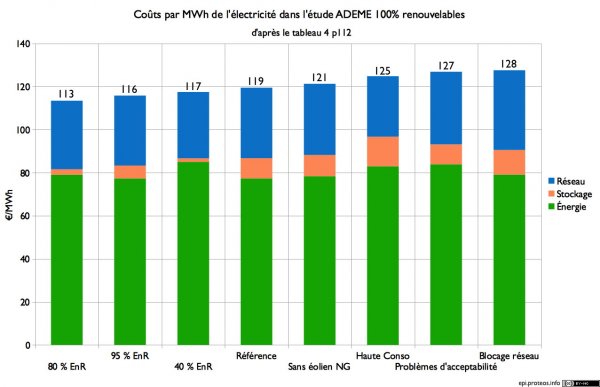

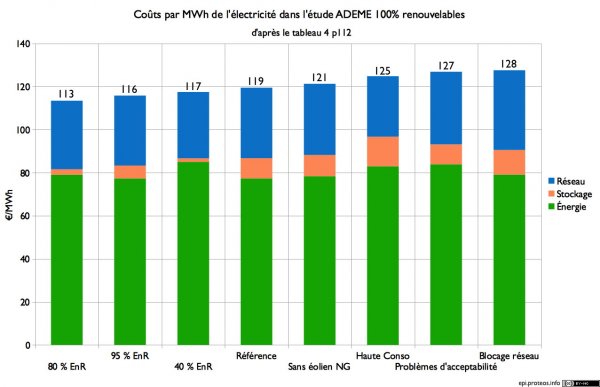

- Un scénario où la demande est plus forte: 510 TWh contre 422TWh. C'est le 3e pire cas au niveau des coûts à cause de l'usage de certaines des technologies les plus chères qui sont écartées de ce fait du scénario de référence. Mais on reste à 5% du coût au MWh du scénario de référence, contrairement à ce que disent les titres (cf plus bas).

- Un scénario où il y a moins d'hydroélectricté disponible. En conséquence, c'est plus cher car il faut à la fois installer des moyens de production supplémentaires, accompagnés d'un peu de stockage et de réseau. Le MWh est 3% plus cher que dans le scénario de référence.

- Un scénario où les énergies marines sont nettement moins chères. Surprise: le coût au MWh est moins élevé en conséquence (-5%). Ça permet de constater que quand les prix baissent, on paie moins cher. C'est un scénario qui pourra laisser un peu d'espoir aux partisans de ces énergies, dont les perspectives sont pratiquement inexistantes si elles restent aussi chères et que le stockage baisse ses prix comme prévu par le scénario de référence.

- Un scénario où le coût des lignes THT est doublé. C'est le pire cas au niveau des coûts au MWh (+8%)! Ça s'explique par le fait que la simulation se met à installer des moyens de production chers et à renforcer le stockage. Combiné au dernier scénario, ça montre que le NIMBY est potentiellement très toxique pour les énergies renouvelables électriques (cf plus bas).

- Un scénario où on accepte 5% d'électricité non-EnR fabriquée en France et un autre où on en accepte 20%. Ces scénarios permettent de s'apercevoir que le stockage, même avec les hypothèses les plus optimistes ne fait pas vraiment le poids face aux combustibles fossiles, même frappés par un prix du carbone de 100€/tonne. Le scénario avec 80% d'EnR est le moins cher à coût du capital constant (-6%). Le stockage de long terme disparaît totalement au profit des turbines à gaz: c'est peut-être la meilleure preuve qu'il est très difficile de se débarrasser des combustibles fossiles. Les combustibles fossiles remplissent actuellement la fonction qui est dévolue au stockage de long terme, puisque le stockage d'énergie est juste une sorte de tas avec des choses à brûler quand on besoin d'énergie

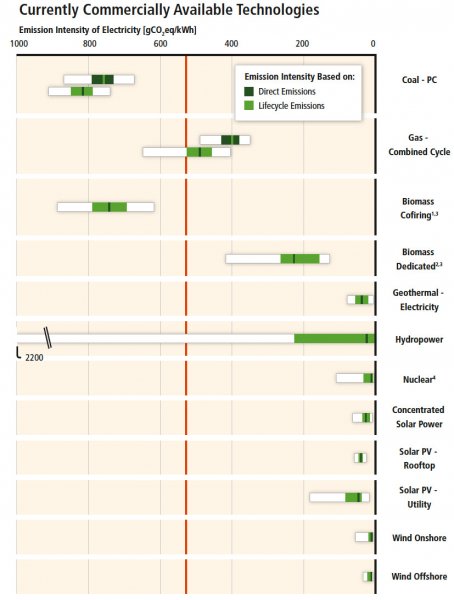

- Un scénario avec 40% d'EnR où le nucléaire apparaît en force. Arrive à rester moins cher malgré le prix du nucléaire dans la fourchette haute des énergies: le stockage est quasi-totalement éliminé à part le pompage, le réseau est fortement diminué, ce qui compense le coût du nucléaire.

- Un scénario sans solaire PV. C'est un des plus chers (presqu'autant que le scénario haute consommation), car il faut recourir aux énergies marines — les plus chères de l'étude — et augmenter les capacités de stockage. Cette variante montre le côté relativement complémentaire du PV avec l'éolien.

- Un scénario sans éolien avec de grands rotors. Un peu plus cher (+2%), il suffit juste de jouer à la marge sur le PV, le réseau et le stockage. Cette variante montre à mon sens — même s'il est difficile d'en être sûr vue qu'elle n'est pas très détaillée — que la flexibilité du stockage permet d'amortir le profil plus intermittent.

- Un scénario avec un taux d'actualisation de 2%, extraordinairement faible. Sans surprise, c'est le moins dispendieux des scénarios: quand des moyens de production à coûts fixes sont financés presque gratuitement, c'est forcément moins cher!

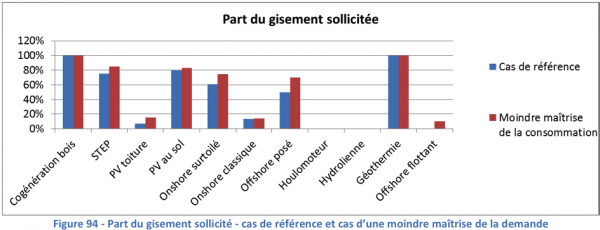

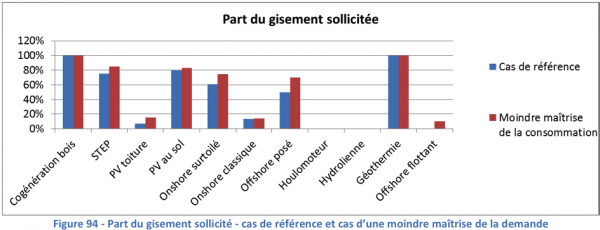

- Un scénario où l'éolien terrestre est plafonné à 47GW environ, soit 2 fois moins que l'optimum de la simulation, et le PV de grandes dimensions à 24GW, une baisse d'un tiers. C'est le 2e scénario le plus cher (+7%) car ce sont les moyens de production les moins chers de l'étude. Il faut recourir aux énergies marines pour combler le manque. Dans ce scénario, le NIMBY est un gros problème pour tout le monde, y compris pour bâtir le réseau (cf variante 4.) d'où sa forte toxicité potentielle.

Les problèmes du document

Le premier problème de ce document, c'est qu'il n'est pas fini. Outre qu'il n'y a pas de résumé et qu'on peut facilement noter la présence de coquilles et de phrases bizarres, cela donne sans doute lieu à un contre-sens. Une des conclusions du rapport est que la maîtrise de la demande est un élément clé pour limiter le coût

(titre p84) mais que les contraintes d'acceptabilité liées au réseau ne sont pas un obstacle

(titre p86) ou encore que de fortes contraintes d’acceptabilité sociale sont compatibles avec un mix 100% renouvelable

(titre p81). Ces phrases sont assez attendues dans un rapport de ce type, qui est après tout souvent commandé pour montrer la faisabilité du scénario étudié et relayer ce que pense le commanditaire. Mais en fait, la figure 77 (p71, oui, il faut suivre) qui sert de base à la publicité pour la maîtrise de la demande est fausse: le MWh ne coûte pas 151€ dans le cas de la haute consommation mais 125€ comme indiqué p112 dans le dernier tableau ainsi que dans la discussion p85. La différence est due au fait que sur la figure 71, le coût total est divisé par une consommation fixe de 422TWh et non par la consommation de la variante… D'ailleurs si on lit le dernier tableau pour les coûts totaux — qui paraît coller avec les hypothèses, lui — on voit que toutes les variantes, sauf une, se tiennent dans ±8% du scénario de référence. L'exception est le cas où le coût du capital est de 2%. On peut trouver la répartition des coûts pour certains scénarios sur le graphe ci-dessous:

Que l'augmentation de la consommation ne soit pas un gros problème découle en fait des hypothèses prises. Régulièrement des études sur le potentiel des énergies renouvelables trouvent qu'il y a potentiellement assez d'énergie à capter pour couvrir les besoins de consommation de n'importe quel pays développé. Donc tant que les gisements d'énergie peu chères ne sont pas épuisés, l'augmentation du volume d'énergie produite n'est pas un problème de coûts. C'est donc naturellement que dans le scénario à forte consommation, où les énergies chères sont peu utilisées, que le coût de production de l'électricité «primaire» augmente dans des proportions raisonnables (+6%). D'ailleurs, il est important de remarquer que la contradiction dans le discours plaidant à la fois pour de fortes économies d'énergie et assurant que les énergies renouvelables vont devenir peu chères très bientôt: les économies d'énergies ne sont nécessaires que si toutes les sources d'énergies sont chères dans le cas contraire, elles ne servent que comme une sorte d'assurance contre une forte hausse des prix.

Par contre, ce qui pourrait se produire, c'est une forte hausse des besoins de stockage et de renforcement du réseau. On note effectivement une augmentation du coût du stockage dans le scénario à haute consommation … mais la modélisation du réseau, qui inclut des frais fixes, a pour conséquence que le scénario à haute consommation a les coûts de réseau par MWh consommé les plus bas! Les deux se compensent à peu près et on touche là à une des limites de la simulation.

Par contre, ce qui pourrait se produire, c'est une forte hausse des besoins de stockage et de renforcement du réseau. On note effectivement une augmentation du coût du stockage dans le scénario à haute consommation … mais la modélisation du réseau, qui inclut des frais fixes, a pour conséquence que le scénario à haute consommation a les coûts de réseau par MWh consommé les plus bas! Les deux se compensent à peu près et on touche là à une des limites de la simulation.

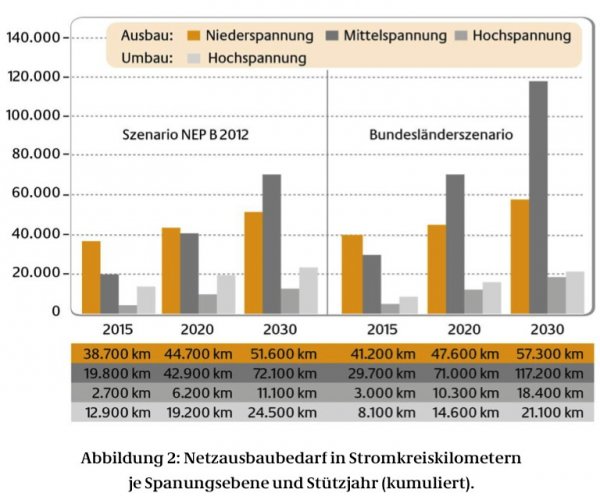

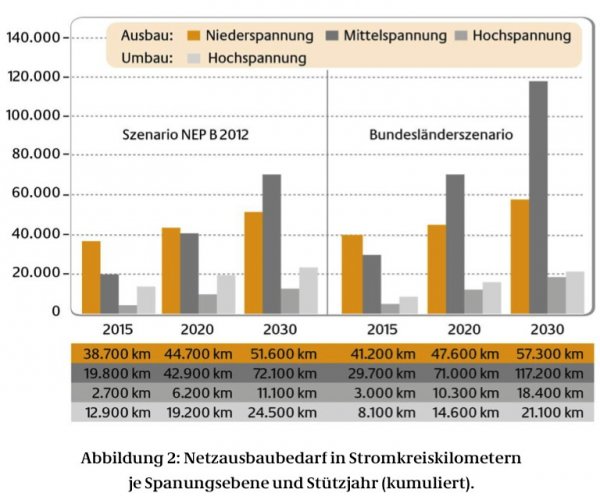

En effet, le modèle suppose que le coût du réseau de distribution jusqu'aux lignes haute tension de 63 et 90kV est supposé fixe (p69). Or, plus il y a de moyens de production décentralisés, comme l'éolien ou le solaire PV, plus il faut renforcer le réseau, de la basse tension aux lignes haute tension, et non seulement les lignes THT pour le transport à grande distance. En effet, le solaire PV sur toiture est branché sur le réseau de distribution mais la puissance produite dépasse facilement la puissance couramment consommée pour une habitation, les grandes centrales solaires et l'éolien sont souvent connectés au réseau haute tension. L'étude ignore donc ce poste de coûts, pour être réellement représentatif, il aurait sans doute ajouter un petit quelque chose. C'est en tout cas ce que laisse penser un document de la Dena allemande dont on peut simplement extraire un graphe, en se rappelant que le réseau basse tension est tout de même moins cher au km que les lignes THT:

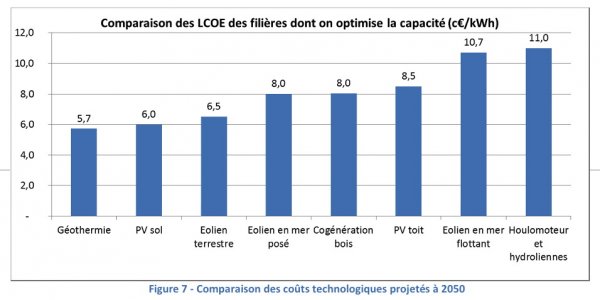

Quant aux prix, il est important de se rappeler que ce sont les hypothèses de départ et non les conclusions de l'étude: en d'autres termes, le mix final et les coûts donnés à la fin dépendent directement de ces paramètres. Or, il s'avère que les projections à long terme sont dans le domaine de l'énergie le plus souvent fausses; il n'est qu'à voir la qualité des prévisions en ce qui concerne le prix du pétrole. Les hypothèses prises sont résumées par les figures suivantes:

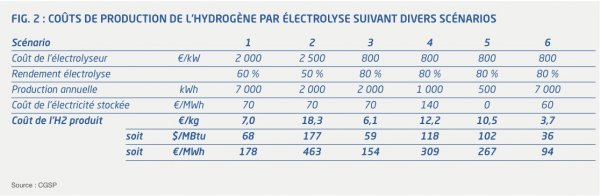

Il est aussi important de connaître le taux d'actualisation pris pour estimer ces coûts: 5.25%. Malheureusement, pour des installations de production, le taux le plus souvent choisi est 8%, en sus de l'inflation. C'est par exemple le taux pris par la Cour des Comptes et EDF pour évaluer les coûts du nucléaire actuel. Avec un taux aussi bas, et en prenant pour base une note du Syndicat des Énergies Renouvelables, on trouve qu'actuellement avec un taux de 5.25%, l'éolien devrait coûter aux alentours de 60€/MWh… La note du Syndicat des Énergies Renouvelables, venant en réponse à un rapport de la CRE trouvant en substance que les rentabilités étaient trop élevées, malgré un rythme d'installation atone, montre que peu sont prêts à investir avec une rentabilité aussi faible. D'un autre côté on voit des technologies fort chères ou quasiment inexistantes baisser radicalement leurs prix. C'est ainsi le cas de sources comme la biomasse ou l'éolien en mer. L'éolien en mer a fait l'objet d'appel d'offres et le prix est ressorti à environ 200€/MWh (sans compter l'indexation) par deux fois. De même les technologies de stockage sont actuellement quasi inexistantes, une seule existe vraiment: les stations de pompage. Dans ce cadre, la technologie de conversion par électrolyse semble se voir attribuer une baisse de prix d'un facteur 4 par rapport à ce qui attendu pour une construction aujourd'hui. Quant au stockage de court terme, il s'agit selon les propres termes du rapport d'une

Il est aussi important de connaître le taux d'actualisation pris pour estimer ces coûts: 5.25%. Malheureusement, pour des installations de production, le taux le plus souvent choisi est 8%, en sus de l'inflation. C'est par exemple le taux pris par la Cour des Comptes et EDF pour évaluer les coûts du nucléaire actuel. Avec un taux aussi bas, et en prenant pour base une note du Syndicat des Énergies Renouvelables, on trouve qu'actuellement avec un taux de 5.25%, l'éolien devrait coûter aux alentours de 60€/MWh… La note du Syndicat des Énergies Renouvelables, venant en réponse à un rapport de la CRE trouvant en substance que les rentabilités étaient trop élevées, malgré un rythme d'installation atone, montre que peu sont prêts à investir avec une rentabilité aussi faible. D'un autre côté on voit des technologies fort chères ou quasiment inexistantes baisser radicalement leurs prix. C'est ainsi le cas de sources comme la biomasse ou l'éolien en mer. L'éolien en mer a fait l'objet d'appel d'offres et le prix est ressorti à environ 200€/MWh (sans compter l'indexation) par deux fois. De même les technologies de stockage sont actuellement quasi inexistantes, une seule existe vraiment: les stations de pompage. Dans ce cadre, la technologie de conversion par électrolyse semble se voir attribuer une baisse de prix d'un facteur 4 par rapport à ce qui attendu pour une construction aujourd'hui. Quant au stockage de court terme, il s'agit selon les propres termes du rapport d'une méta-technologie

. Pour le dire simplement, il s'agit donc bien là d'hypothèses, qui servent de point de départ à la simulation: en déduire qu'un système 100% renouvelable serait bon marché est une erreur de logique, le système est à un prix raisonnable si ces hypothèses se vérifient.

Le nucléaire se voit attribuer un prix de 80€/MWh pour un facteur de charge de 80%. Avec l'utilisation réelle, le prix ressort d'ailleurs plutôt à 85€/MWh soit environ 30% de plus que l'éolien terrestre dans le modèle. Ce prix correspond grosso modo au prix de Flammanville 3 avant les derniers retards annoncés, soit 9.5G€, avec le taux d'actualisation annoncé (5.25%). La simulation avec peu d'énergie renouvelables est aussi désavantagée par divers facteurs: par exemple, il y a une limite basse pour l'installation de solaire PV sur toiture, une technologie chère dans le modèle, qu'on peut remplacer par l'alternative similaire des grandes centrales PV. Ça coûte environ 400M€ annuels avec les hypothèses du modèle, soit 1€/MWh. Ça peut sembler dérisoire, mais dans une simulation où tous les scénarios se tiennent dans quelques pourcents, ça a son importance. Mais un scénario avec 55% de nucléaire reste alors compétitif malgré le surcoût et les hypothèses de prix enthousiastes pour le stockage. Enfin, il est remarquable que le scénario le moins cher soit celui où les combustibles fossiles produisent quasiment autant qu'en 2012 … les émissions ne baissent que grâce à la fin du charbon et du fioul dans la production d'électricité. C'est la preuve s'il en fallait une qu'il sera difficile de se débarrasser des combustibles fossiles.

Quelques conclusions

Cette étude est la plus réaliste des diverses études modélisant une production d'électricité 100% renouvelable que j'aie lue. Grâce aux installations hydrauliques déjà présentes aujourd'hui et la gestion du stockage — innovante me semble-t-il — la puissance d'entrée des moyens de stockage reste limitée, de même que l'utilisation de la gestion active de la demande. La somme des deux ne dépasse pas 40GW, ordre de grandeur de la puissance moyenne consommée. On reste dans un domaine raisonnable, contrairement par exemple à l'étude du Fraunhofer Institut, où la somme des deux atteignait parfois 100GW, à peu près 2 fois la puissance moyenne consommée. Même si tout n'est pas parfait, cette étude permet de déterminer quels sont les éléments de succès ou de d'échec d'une production nationale d'électricité basée entièrement sur les énergies renouvelables. Il faut donc de l'éolien et du solaire PV abordable, une capacité d'importation intacte, du stockage peu cher et découpé en catégories d'utilisation (court terme, semaine, long terme), de la demande gérable à distance, typiquement basée sur le chauffage électrique. Les facteurs d'échec sont, à part la non-réalisation des facteurs de succès, le développement d'une réaction de NIMBY qui empêcherait la construction de nombreuses éoliennes et de lignes THT.

Comme les capacités à prévoir les inventions et les prix dans le futur sont très limitées, la question à laquelle répond cette étude est en fait: «que faut-il changer pour que la production d'électricité en France se fasse totalement à partir d'énergies renouvelables?». La réponse est donc que l'éolien terrestre doit baisser ses prix de 25%, l'éolien en mer d'un facteur 3 environ, le solaire PV d'un facteur 2, et surtout des technologies de stockage doivent apparaître et devenir compétitives. On doit aussi interdire quasiment les combustibles fossiles, faute de quoi leur utilisation ne serait pas très différente d'aujourd'hui. En outre, une gestion dynamique de la demande doit être mise en place, en grande partie basée sur le chauffage électrique — qu'on ne doit donc pas décourager — et pour le reste sur les voitures électriques — qui doivent encore se tailler une part de marché significative. Enfin, aucun mouvement de NIMBY ne doit apparaître.

Il n'est pas certain que tous ces points puissent se réaliser aisément tous en même temps: pour prendre un exemple, parmi les supporters des éoliennes, on ne trouve pas spécialement de supporters du chauffage électrique ou des lignes à haute tension. Dans un autre genre, la Cour des Comptes avait constaté que 40% des permis de construire d'éoliennes étaient retoqués par l'administration et sur ceux qui passaient ce filtre, un tiers était attaqué par des personnes privées. Au Royaume-Uni, les éoliennes sont suffisamment impopulaires pour que le parti conservateur compte en son sein de nombreux opposants à leur déploiement dans ses rangs, et cette opposition sert de justification au développement de l'éolien en mer pour lequel, d'ailleurs, l'opposition populaire aux éoliennes terrestre est en ce moment à peu près la seule justification.

Pour finir, il reste à répondre la question «Que faire à la vue de cette étude?». La réponse est en fait «pas grand-chose!». Si chercher à faire que les prix des énergies renouvelables baisse ne veut pas dire en installer massivement. En effet, elles sont aujourd'hui nettement plus chères que les alternatives. Par exemple, la position de départ de d'EDF avant négociation est de demander 55€/MWh pour l'électricité nucléaire venant d'un parc rénové, bien moins cher que ce qui est présenté dans l'étude. En conséquence, d'ici 2035, il n'y a pas besoin de changer grand-chose. De plus, certains tarifs de rachat pour les énergie renouvelables restent très élevés et produiront des effets jusque dans les années 2040, comme par exemple ceux de l'éolien en mer. Dans ce cadre, procéder à un déploiement massif dès aujourd’hui serait se faire mal tout de suite pour espérer que ça aille à peu près bien dans une trentaine d'années!

Pour cela, la plupart des modèles font appel au BECCS pour BioEnergy, Carbon Capture & Storage, en clair, on brûlerait du bois, activité supposée neutre en carbone et on capturerait le CO₂ produit grâce aux technologies de capture et séquestration du carbone. Sachant qu'il est douteux qu'à grande échelle, brûler du bois soit vraiment neutre en carbone et qu'il n'existe qu'une poignée d'usines pratiquant la capture et la séquestration du CO₂ de par le monde, cela paraît tout de même sacrément optimiste! Un autre petit détail: utiliser autant de biomasse nécessiterait d'y consacrer de l'ordre de 5 millions de km² de terres arables, soit un peu plus de la moitié de la superficie des USA… C'est pourquoi on peut affirmer que 2°C, c'est faisable … mais uniquement dans les modèles!

Pour cela, la plupart des modèles font appel au BECCS pour BioEnergy, Carbon Capture & Storage, en clair, on brûlerait du bois, activité supposée neutre en carbone et on capturerait le CO₂ produit grâce aux technologies de capture et séquestration du carbone. Sachant qu'il est douteux qu'à grande échelle, brûler du bois soit vraiment neutre en carbone et qu'il n'existe qu'une poignée d'usines pratiquant la capture et la séquestration du CO₂ de par le monde, cela paraît tout de même sacrément optimiste! Un autre petit détail: utiliser autant de biomasse nécessiterait d'y consacrer de l'ordre de 5 millions de km² de terres arables, soit un peu plus de la moitié de la superficie des USA… C'est pourquoi on peut affirmer que 2°C, c'est faisable … mais uniquement dans les modèles!