Le diagnostic de performance énergétique, largement connu sous son acronyme DPE, a pour but de classer les logements suivant leur consommation d'énergie pour le chauffage et la climatisation ainsi que pour l'eau chaude sanitaire. Fondé sur la directive européenne sur l'efficacité énergétique des bâtiments, dont la première moûture remonte à 2002, il classe d'abord les logements par leur consommation d'énergie primaire mais aussi désormais depuis la réforme de 2021 par leurs émissions de CO2. L'étiquette qui découle du diagnostic est en effet la pire classe obtenue suivant les 2 critères. La réforme de 2021 avait à l'époque suscité des remous car elle était liée aussi à l'interdiction de louer des logements trop mal classés. À l'époque ce sont les mouvements entre classes qui ont le plus interpelé, mais rapidement, c'est la sortie des logements les plus mal classés qui est passée au premier plan, car elle participe à la forte réduction de l'offre locative en France.

Un autre aspect est largement ignoré: le DPE peut-il réellement permettre d'atteindre les buts qui lui sont fixés, à savoir classer les logements entre eux et par là réduire la consommation d'énergie primaire — puisque c'est le critère principal et historique — de la France? La question peut sembler étrange pour un mécanisme en place depuis environ 20 ans maintenant. Cependant, différents indices laissent désormais clairement penser que le DPE est un très mauvais indicateur. Ce n'est pas seulement qu'il viserait un mauvais indicateur, l'énergie primaire, au détriment des émissions de CO2 comme cela lui est souvent reproché, mais c'est surtout que les résultats obtenus iraient directement à l'encontre de l'objectif de classer les logements entre eux de façon fiable sur le critère de l'énergie consommée, surestimant largement l'énergie réellement consommée pour les logements les plus mal classés.

Quelques éléments sur la fiabilité du DPE

La première fois que j'ai eu des doutes sur les estimations conventionnelles de la consommation d'énergie remonte sans doute à 2019, où l'association Sauvons le Climat avait invité un chercheur à présenter le programme européen Cordées et les résultats obtenus avec la mesure des consommations réelles d'énergie au quartier des Batignolles, nouvellement érigé, à proximité du nouveau palais de justice de Paris. À la page 14 de la présentation, on se rendait compte que les consommations mesurées étaient très supérieures à la cible visée lors de la construction, avec une forte dispersion. Cependant, le reste des données montre que la situation des logements récents n'est pas la véritable préoccupation.

En septembre 2020, juste avant la mise en œuvre de la réforme, le ministère du logement publia un document intitulé «Le parc de logements par classe de consommation énergétique au 1er janvier 2018». À la page 11, on pouvait voir la proportion de logements mal notés par département. On pouvait constater que, mis à part éventuellement Paris, les plus fortes proportions de logements mal notés se situaient dans des départements connus pour leur dynamisme démographique: le Cantal, la Creuse, la Nièvre, etc. Cela signifie que les logements les plus anciens recevaient les plus mauvaises notes, pas nécessairement à tort. On voyait aussi que les logements chauffés à l'électricité étaient très largement surreprésentés dans les pires classes, car ils représentaient plus de la moitié des classes F et G, conséquence directe du classement par énergie primaire qui multipliait alors la consommation d'électricité par 2.58. Cette répartition n'était pas sans poser quelques questions: en effet cela signifiait que des logements avaient vu une installation du chauffage électrique bien après leur construction, mais probablement dans les années 80, au détriment d'énergies moins onéreuses et alors même qu'ils sont censés être les moins bien isolés. Dans le passé, le ratio du prix de l'électricité par rapport à celui du fioul ou du gaz a pu être supérieur à 2.58, ce qui aurait dû amener à considérer d'autres énergies. De plus, parmi les départements les plus mal notés, on notait la présence de certains départements "froids" comme le Cantal, nécessitant plus de consommation réelle à consommation conventionnelle égale. Si on fait l'hypothèse de la rationalité économique des propriétaires occupants, ce constat doit amener à douter de la qualité des plus mauvaises notes.

D'ailleurs, la note fait quelques remarques intrigantes. Ainsi, à propos de la méthode utilisée, il convient toutefois de garder à l’esprit que la méthode 3CL n’est pas parfaitement adaptée aux logements construits avant 1948 et conduit probablement à une surestimation de la consommation de certains d’entre eux, qui peuvent avoir été construits avec des matériaux plus isolants que ceux pris en compte par la méthode 3CL

. Et à propos d'une enquête précédente sur le même sujet, certains éléments suggèrent en effet que l’enquête Phébus a pu conduire à une surestimation de la proportion de passoires. En particulier, une étude comparant les consommations conventionnelle et réelle observées dans l’enquête avait conclu que les écarts importants entre ces deux grandeurs pour les logements de classes F ou G ne pouvaient s’expliquer que très partiellement par des comportements de restriction de consommation, amenant les auteurs à soulever une interrogation quant à la qualité des DPE réalisés dans le cadre de l’enquête.

Rien de tout cela n'amenait toutefois les auteurs à une remise en cause de la méthode utilisée par les DPE.

Ces résultats ne m'en avaient pas moins paru étranges.

En décembre 2020, RTE publia un rapport intitulé Réduction des émissions de CO2, impact sur le système électrique : quelle contribution du chauffage dans les bâtiments à l’horizon 2035 ?

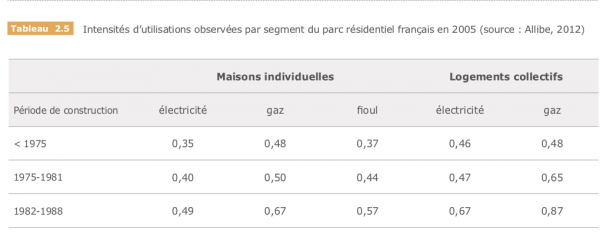

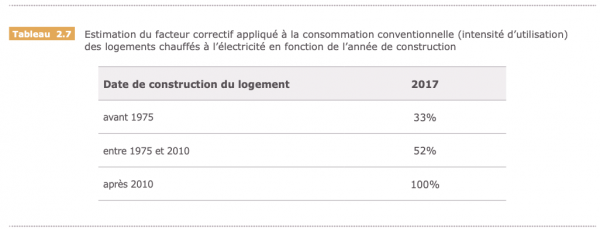

. Ce rapport contient une foule d'informations; dans le cas qui nous occupe, il contient des tableaux intéressants pages 123 et 125 reproduits ci-dessous, accompagné d'un texte éclairant.

Il se trouve qu'EDF ne peut concilier directement les consommations conventionnelles et les consommations réelles sans redresser les premières par un facteur correctif. Ce facteur correctif est toujours inférieur ou égal à 1, et de plus en plus petit à mesure que la date de construction est ancienne. C'est ainsi que pour EDF, les logements chauffés à l'électricité construits avant 1975 ne consomment qu'environ un tiers de leur consommation conventionnelle. Une explication souvent avancée est que les ménages, notamment les indigents, restreignent leur consommation quitte à supporter le froid. Cependant, au vu de l'ampleur de la correction, on peut fortement douter que ce soit la cause principale. Un modèle de base pour la consommation d'énergie pour le chauffage est celui de la résistance thermique: la quantité d'énergie nécessaire pour maintenir une différence de température entre l'extérieur et l'intérieur est proportionnelle à cette dernière. Si on prend comme température moyenne extérieur en hiver 7°C et la température conventionnelle de 19°C, ne consommer qu'un tiers de l'énergie prévue devrait amener une température intérieure de 11°C, en moyenne sur tous les logements dans la classe considérée, ce qui paraît extrêmement peu probable vu que la population considérée mélange pauvres et riches. Une explication alternative est que la consommation conventionnelle des logements les plus mal notés est très largement surestimée par rapport aux besoins réels.

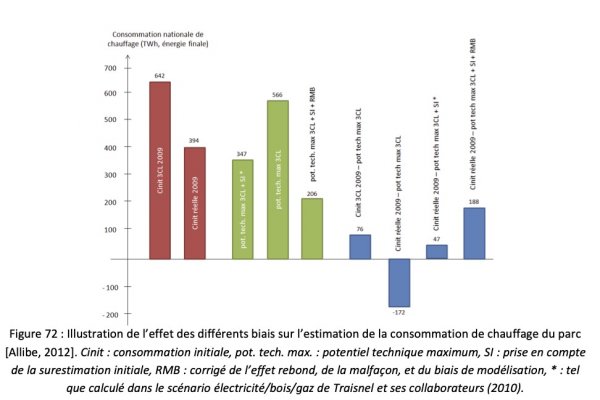

Le premier tableau est extrait de la thèse de Benoît Allibe. En plus des tableaux reproduits ci dessus, on y trouve un graphe (p169) comparant entre autres la consommation réelle d'énergie pour le chauffage en 2009 — 394 TWh — et celle qu'on peut estimer via les DPE — 642 TWh. La consommation d'énergie est largement surestimée si on se fie au DPE. Se fier au DPE pour estimer les économies d'énergie possibles revient alors à les surestimer très largement.

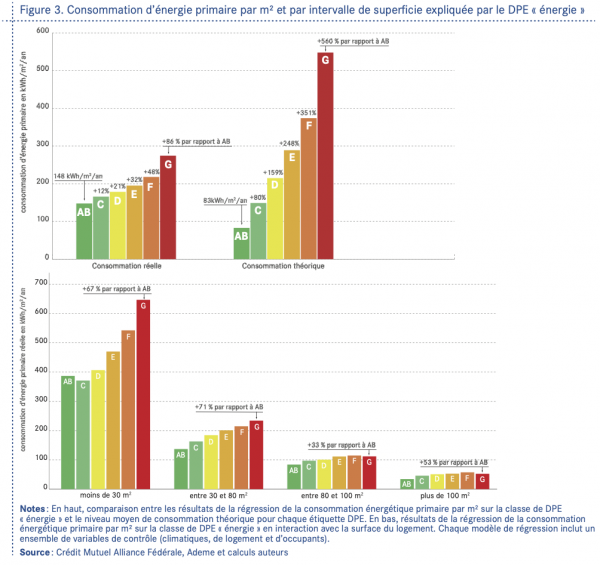

En janvier 2024, le Conseil d'Analyse Économique a publié une note intitulée «Performance énergétique du logement et consommation d'énergie : les enseignements des données bancaires». L'idée de départ de la note est de comparer les dépenses énergétiques, telles qu'appréhendées via les versements de particuliers aux fournisseurs d'énergie, aux dépenses conventionnelles d'énergie correspondant au DPE. Leur conclusion est que le DPE surestime massivement les dépenses pour les logements mal notés, spécialement pour les grands logements. Les auteurs trouvent ainsi que la consommation des logements classés F et G est surestimée d'un facteur 2 environ. Par contre, pour les logements classés A et B, ils constatent que la consommation réelle est de 80% plus élevée que la conventionnelle.

Si on exclut les logements de moins de 30m², sans doute victimes du fait que le mode de calcul du DPE ne tient pas compte qu'il y a au minimum une personne dans un logement, on constate que toutes les classes voient leur consommation surestimée, sauf les classes A et B pour les logements entre 30 et 80m². Or il se trouve que l'essentiel des logements classés A et B sont récents et que la majeure partie des logements neufs tombent dans cette classe, qui d'ailleurs représente aussi les 2/3 de l'échantillon total des logements de l'étude. Les auteurs attribuent les 2/3 de l'écart à une question de comportement, en prenant pour référence une publication externe à leur expérience. Autrement dit, à hauteur des 2/3, les habitants choisiraient de maintenir une température plus basse dans leur logement. Il ferait donc en moyenne environ 15°C dans les logements classés F et G l'hiver si on retient une température moyenne extérieure de 7°C. C'est toujours un écart important, surtout si on tient compte des appels du gouvernement à respecter les températures conventionnelles en 2022 quand les centrales nucléaires manquaient cruellement. À quoi bon ces déclarations si les gens ne se chauffent déjà pas à 19°C? Par ailleurs, on voit que les habitants de grands logements ne se chauffent pas ou alors ne vivent que dans une toute petite partie de leur logement l'hiver.

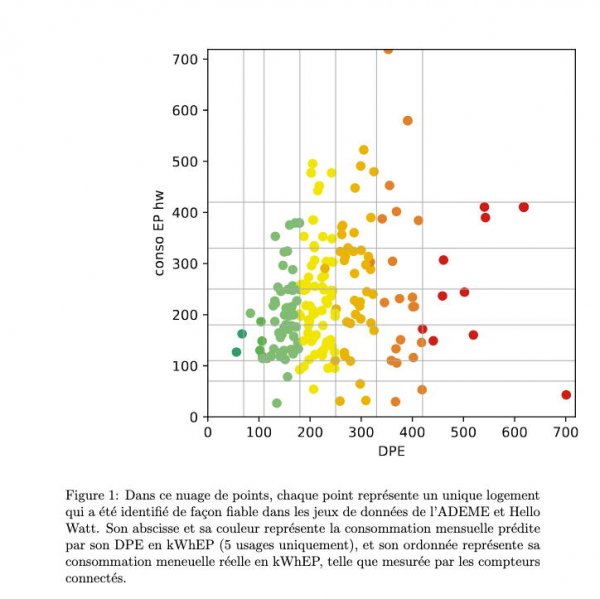

Enfin en janvier 2023, Hellowatt, une société de conseil, a publié une note comparant les DPE aux consommations d'électricité, qu'il peut connaître en quasi temps réel grâce aux compteurs Linky. Je n'avais pas connaissance de cette note jusqu'à l'article récent publié sur le site des Électrons Libres. Le graphe ci dessous montre ce qu'ils ont trouvé. En conclusion, il est affirmé que nous avons montré que le DPE est un mauvais prédicteur de la consommation énergétique des logements, au point qu’une estimation purement aléatoire aurait des performances similaires

.

L'aveuglement de l'état

Dans un rapport récent, la Cour des Comptes se penche sur le DPE. La question de la fiabilité du DPE n'y est abordée que sous l'angle de la fraude commise par les diagnostiqueurs, sous la pression de l'intérêt des propriétaires. Il n'est nullement envisagé que la méthode elle-même puisse mener à des résultats faux, cette hypothèse est évacuée en 2 phrases p40, pour laisser la place à un graphe montrant une accumulation des diagnostics proches des frontières ayant des conséquences légales à plus ou moins long terme. Cette accumulation est largement attendue à cause, justement, des conséquences légales d'une mauvaise note, sans parler de l'éventuelle perte de valeur du logement. Des initiatives peuvent toujours être prises pour lutter contre ce phénomène, mais il faudrait que le diagnostic ait lieu sans aucune liberté d’appréciation laissée au diagnostiqueur, ce qui est impossible avec la méthode en vigueur. Au contraire, s'il existe en fait une forte variabilité due à la méthode utilisée, comme le laisse entendre les résultats ci dessus, cette accumulation devient extrêmement facile, cette variabilité étant alors tranchée au profit du diagnostiqué, le diagnostiqueur ne prenant aucun risque au vu des aléas réels. De plus, si les consommations réelles sont inférieures pour ces catégories, personne ne se plaindra jamais, la performance constatée sur facture étant toujours ou presque meilleure.

Or l'hypothèse que la méthode soit fondamentalement viciée devrait occuper le premier plan. En effet, on trouve trace du fait que les logements soient en moyenne plus chauds que la température conventionnelle, et non fortement inférieure comme le laisserait entendre une solution aux différences entre consommations réelles et observées via les comportements, c'est à dire par la restriction du chauffage par les moyens budgétaires des occupants. L'ensemble de la littérature que j'ai pu trouver met les comportements des occupants au premier plan et ne traite l'hypothèse d'une évaluation fausse qu'en dernier ressort. C'est ainsi le cas d'un article publié en 2017 par le ministère de l'environnement dans un recueil Les ménages et la consommation d'énergie

, sous le titre Quels enseignements tirer de l’enquête Phébus sur la question de l’effet rebond ?

, cet aspect est relégué à la fin, où les auteurs trouvent qu'en immeuble avec chaufferie centrale, non contrôlée par les résidents, les logements classés G consomment 40% de moins que la consommation conventionnelle.

L'hypothèse d'une méthode viciée permet aussi d'expliquer certains résultats étranges sans cela. L'article Quel est l’impact des travaux de rénovation énergétique des logements sur la consommation d’énergie?

publié dans la Revue de l'Énergie avait fait un peu de bruit lors de sa parution. La conclusion mise en exergue était que 1000€ de dépenses en travaux n'entrainaient qu'une baisse de 8€ des dépenses annuelles d'énergie. Une étude récente de l'INSEE, Effets de l'isolation thermique des logements sur la consommation réelle d'énergie résidentielle

, donne des résultats similaires, dans un tableau mis au bout des annexes, où 1000€ engagés dans la rénovation d'un logement chauffé à l'électricité se traduit par une économie d'environ 8€ et environ 11€ si le logement est chauffé au gaz. Cette dernière étude montre aussi que les économies effectivement constatées ne représentent qu'une faible part des économies prévues par une estimation conventionnelle: 25% dans le cas de l'électricité et 60% dans le cas du gaz. Si les logements ont en fait des performances proches contrairement à ce que laisse penser leur note, effectuer une rénovation ne donnera qu'un gain tant financier qu'énergétique faible, même si un gain de confort perçu important est enregistré. Les effets rebonds, souvent invoqués, n'ont alors à jouer qu'un rôle mineur.

Qu'il n'y ait aucune prise en compte de cette hypothèse est logique dans le cadre de la politique menée par l'état de longue date. La question des dépenses énergétiques dans les logements est abordée préférentiellement sous l'angle de l'énergie consommée, variable mise au premier plan alors qu'elle ne devrait être qu'un indicateur de second rang, derrière le coût total d'un système de chauffage ou encore les émissions de CO2. On peut le voir en dehors du domaine du chauffage, les normes de construction ne laissant aucune place à la climatisation des logements. Les normes de consommations conventionnelles sont en effet de plus en plus dures à mesure qu'on va vers le sud, zone où pourtant l'usage de la climatisation devient de plus en plus clairement obligatoire. C'est ainsi aussi qu'on laisse les écoles sans climatisation ou encore qu'on peut avoir l'idée de construire une serre accueillant du public sans y mettre la climatisation.

Le DPE ne peut remplir son office car il ne se base sur aucune mesure véritable, il n'y a que des jugements qualitatifs. Pourtant, au moins pour les énergies de réseau, il est sans doute possible de se baser sur des mesures nettement plus directes. En effet, tant pour le gaz que pour l'électricité, les consommations sont disponibles en quasi temps réel grâce aux nouveaux compteurs. Il existe aussi des thermomètres enregistreurs. La température extérieure est elle aussi disponible rapidement. On pourrait donc imaginer relier les 3 séries de données pour estimer les performances de chaque logement. Lors de la réforme du DPE en 2021, ces choses existaient déjà, pourtant, il a été choisi de poursuivre avec les évaluations qualitatives. Le rapport de la Cour des Comptes juge l'usage de données réelles comme impossible du fait de contraintes comme le fait de devoir vider le logement de ses habitants, mais il est probable qu'en fait on puisse faire une estimation raisonnablement fiable, même avec le logement habité, à l'aide de données s'étalant sur plusieurs mois.

En conclusion, il me semble que l'hypothèse que les DPE donnent des estimations largement faussées est aujourd'hui celle qui devrait occuper le premier plan. Cette hypothèse permet d'expliquer une longue suite de résultats et aurait dû inciter à changer de méthode, dès la dernière réforme. Malheureusement, au contraire, le gouvernement a décidé d'une politique de rénovations obligatoires basée sur l'indicateur tel qu'il était. Sous le gouvernement Hollande, il fut décidé de rendre obligatoire les rénovations des logements classés F et G, sans toutefois prévoir grand chose si rien n'était fait. Puis sous le premier quinquennat de Macron, d'interdire les locations pour les logements les plus mal notés. C'est ainsi que certains logements sont interdits à la location, sans doute une des causes de la baisse de 60% des annonces de locations depuis 2019. Ça n'a rien d'étonnant, car même l'IGF reconnaît que la rentabilité locative des logements est faible (Tableau 17): comment justifier une rénovation qui ne donnera pas les économies attendues pour le locataire et aucune hausse du loyer pour le propriétaire? La sagesse indiquerait de revenir sur ces décisions. Il s'avère qu'au lieu de cela, on a décidé de foncer dans le mur: la dernière moûture de la directive européenne définissant le DPE oblige désormais (article 9) les états à éliminer les logements les plus mal notés. Les partis centristes se demandent sans doute pourquoi les extrémistes sont aussi populaires dans notre pays. Il est possible que le choix de baser des politiques avec des conséquences graves sur des indicateurs faux participe à cette popularité.