Il y a quelques jours Le Monde publiait un article qui revenait sur le peu de succès des opérateurs alternatifs aux monopoles de fait dans la fourniture du gaz et de l'électricité, GDF et EDF. On peut retirer de l'article qu'aller voir la concurrence représente en fait peu d'intérêt — à peine quelques pourcents sur la facture dans le meilleur des cas — à cause de la prééminence de coûts régulés encore forts présents et de la compétitivité de l'électricité nucléaire. Les perspectives d'avenir tracées à la fin semblent considérer que cet état de fait va durer à moins qu'une tarte à la crème prenne subitement de l'importance: que des clients paient pour être au service des producteurs pour recevoir des conseils sur comment mieux consommer.

Il me semble qu'il est important de revenir sur les raisons probables de cet échec et de le comparer avec le succès de l'ouverture à la concurrence des télécoms.

Les raisons du succès de la concurrence dans les télécoms

Au début des années 90, l'UE a décidé d'ouvrir les marchés des télécoms à la concurrence. Dans un premier temps, cela a concerné les minutes de communication. On pouvait alors choisir un opérateur qui facturerait moins cher les minutes de communication. Cela reposait en fait, au départ, sur la capacité des opérateurs alternatifs à acheter en gros les minutes de communication puis de les revendre au détail, sans être encombré par les dépenses de personnel de France Télécom. La liberté de tarification de France Télécom sur le marché de gros était réduite de façon à ce que les concurrents puissent s'installer, un peu à la manière dont comptent agir les autorités communautaires sur le marché de l'énergie. Mais, moins de 20 ans plus tard, cet aspect est marginal sur le marché des télécoms: le véritable succès vient d'ailleurs, de profonds changements technologiques.

Le premier changement qu'on peut nommer est l'arrivée à maturité des technologie de transport de l'information par fibre optique. Au début des années 90, ce n'était pas vraiment une nouveauté, le principe était connu depuis 20 ans, mais les progrès ont été si rapides, tant dans les matériaux que dans les techniques de modulation et de multiplexage, que le coût de transport de l'information est devenu nettement plus intéressant. Les fibres sont maintenant incomparablement transparentes, il faut faire parcourir de l'ordre de 15 à 20km pour que le signal perde la moitié de son intensité. Les techniques de modulation ont permis d'augmenter le débit sur un seul canal, les techniques de multiplexage ont permis de multiplier les canaux sur une seule fibre. Il est aussi relativement facile de déployer un réseau de fibre optique: on peut suivre des axes déjà bâtis comme les autoroutes, les voies de chemin de fer; il n'y a pas de grands travaux de BTP à mener, il s'agit en général d'une simple tranchée à creuser sur le bas-côté avec des guitounes pour réamplifier le signal de loin en loin. On peut aussi installer les lasers nécessaires au fonctionnement des canaux au fur et à mesure des besoins, ce qui limite le coût d'investissement initial. Il n'y a aussi aucune opposition au déploiement de ce réseau vu sa faible empreinte. Bref, il est devenu possible de transporter de grandes quantités d'informations sur grandes distances, à un coût raisonnable, sans grandes difficultés d'installation. Cela a permis à de nouveaux entrants de construire leur propre réseau qu'ils ont pu rentabiliser en quelques années.

Le deuxième changement est l'arrivée de l'ADSL. Cette technologie permet d'utiliser le réseau existant pour faire passer nettement plus d'information. Ce réseau étant déjà largement amorti et régulé pour la phase téléphonie classique, cette technologie est peu coûteuse. Le plus dur est d'arriver à ce que des firmes autres que le monopole aient accès au répartiteur pour y installer leurs équipements. Le développement concomitant d'Internet permet d'avoir une demande pour ce type de technologie: finalement, les clients sont prêts à payer plus pour un nouveau service. Les nouveaux arrivants peuvent aussi proposer des services combinés avec Internet, téléphone illimité & télévision: de toute façon le coût marginal de l'octet échangé est pratiquement nul, il s'agit surtout de convaincre les clients de payer les coûts d'investissement dans un premier temps.

Le troisième changement est la téléphonie mobile. Avec la téléphonie mobile, plus besoin de construire un réseau filaire local puisqu'on utilise des bornes radio. Ça permet d'introduire de la concurrence parce qu'installer des bornes radio est moins cher que de construire ce réseau local. Le réseau à longue distance est, lui, construit grâce à la fibre optique. Une nouvelle fois, on apporte un service supplémentaire aux clients, qui sont prêts à payer pour. Les téléphones portables sont devenus des objets communs sans qu'on ait forcé qui que ce soit. Avec les offres à 2€/mois, les offres mobiles sont devenues bien plus compétitives que les offres filaires si on veut «juste» téléphoner. Installer des bornes téléphoniques est devenu un peu plus compliqué dernièrement à cause d'hurluberlus, mais ils ont arrivés trop tard pour empêcher le décollage d'une invention qui est indéniablement profitable à la société.

Au final, la libéralisation des télécoms a été un succès grâce à l'apparition de nouveaux services rendus possibles par des changements technologiques. Cela ne veut pas dire que les sociétés ne formeront pas des oligopoles peu concurrentiels à l'avenir — comme le montre l'exemple de la téléphonie mobile avant l'arrivée de Free ou l'ADSL ailleurs qu'en France — mais qu'en phase de changement technologique, la concurrence peut accélérer les choses et répandre des technologies de façon très rapide. Mais ça ne marche bien que si les clients sont prêts à payer pour ces fameux services supplémentaires. On peut aussi voir que la question des tarifs du téléphone a presque disparu de l'agenda récurrent des politiques: personne ne hurle contre les hausses de tarifs, on constate plutôt des baisses de prix à service constant sous la pression du changement technologique. La demande pour les nouveaux services suffit à rentabiliser rapidement les investissements comme le montre le cas de Free, l'intervention publique est relativement limitée et souvent très technique.

Le cas de l'énergie

Les cas du gaz et de l'électricité sont très différents.

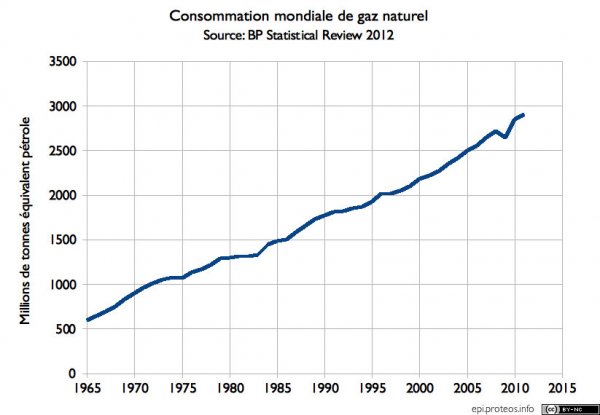

Le gaz est un type d'énergie dont on aimerait se passer pour cause de manque de ressources et d'ennuis climatiques. On n'attend pas non plus de rupture technologique dans le transport du gaz. Investir dans le réseau n'est donc pas forcément très intéressant. Il y a par contre des nouveautés dans la production, avec les gaz non conventionnels qui pourraient résoudre les problèmes d'approvisionnement ... mais aggraver le problème du réchauffement climatique s'ils ne font que s'ajouter aux ressources existantes. Une certaine opposition est aussi apparue contre ce mode de production. L'extension du réseau d'électricité, notamment à haute tension, rencontre une opposition intense de la part de ceux qui habitent à proximité. Impossible donc d'étendre ce réseau sans planification ni implication forte de l'état. Là non plus pas vraiment de rupture technologique en vue: les supraconducteurs ne sont pas spécialement bon marché. Contrairement aux télécoms, il n'y a pas à attendre grand chose de ce côté. La distribution de gaz et d'électricité reste pour l'essentiel et pour le futur prévisible un monopole naturel. C'est d'ailleurs pensé comme tel: les réseaux de transport de gaz et d'électricité sont considérés comme des monopoles naturels à réguler séparément du reste. Pour ce qui est des réseaux locaux, ils sont vus comme les réseaux d'adduction d'eau: des réseaux à concéder — ou pas — qui ne sont rien d'autre qu'une juxtaposition de monopole naturels locaux.

Les fournisseurs finaux pourraient penser procéder comme pour les minutes de téléphone: acheter en gros et vendre au détail, en voulant profiter de moindres frais d'organisation pour être plus compétitif que le monopole naturel. Malheureusement, cette voie est aussi largement barrée: alors que le coût marginal d'une minute de téléphone est très proche de 0, ce n'est pas le cas du m³ de gaz ou, en général, du kWh d'électricité. Les gains d'échelle sont donc fondamentalement limités. On se retrouve rapidement à devoir demander l'intervention de l'état, face à laquelle le monopole en place peut montrer que ses coûts marginaux sont bien réels. On se retrouve au bout du compte avec une tarification qui ressemble plus ou moins à ce qui présidait avant avec la facturation des coûts moyens. Ce n'est donc pas un hasard si on a vu apparaître l'ARENH, prix et conditions diverses fixés par l'état pour l'électricité nucléaire qu'EDF doit vendre à ses concurrents.

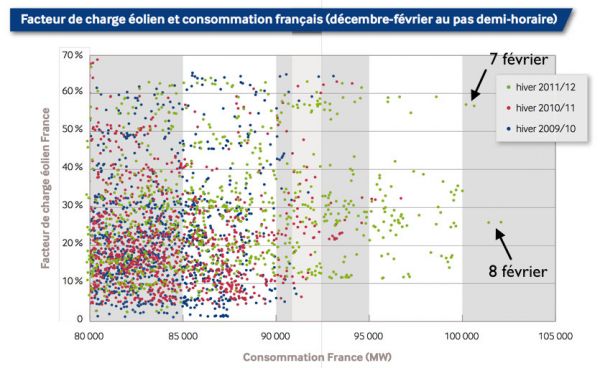

L'autre voie serait de vendre des services supplémentaires. Mais on voit mal quels services nouveaux sont permis par la fourniture d'électricité et vraiment demandés par les clients. On parle beaucoup des smart grids dans ce domaine. Cependant les fournisseurs finaux n'installeront sans doute pas les nouveaux compteurs: il faut s'assurer de la compatibilité mutuelle des équipements et les temps d'amortissement sont plutôt comparables avec des activités de réseau. Ils se contenteront donc des services. Ils proposeraient aux clients de moins consommer: on voit mal ce qu'ils apporteraient de plus que les services d'un architecte ou d'un artisan faisant des travaux chez soi. On voit aussi mal comment ils se rémunèreraient différemment d'un architecte dans ce cas: après les travaux, les volumes vendus diminueraient. Pour le gaz, c'est le service qui semble possible, vu que la diminution de la consommation est l'objectif officiel. Pour l'électricité, les choses sont un peu différentes: là, les smart grids prennent un tour plus orwellien. Il s'agirait de déplacer la consommation pour éviter les pointes ou carrément pallier aux insuffisances de production, qui sont plus ou moins regroupées sous l'appellation consommer mieux

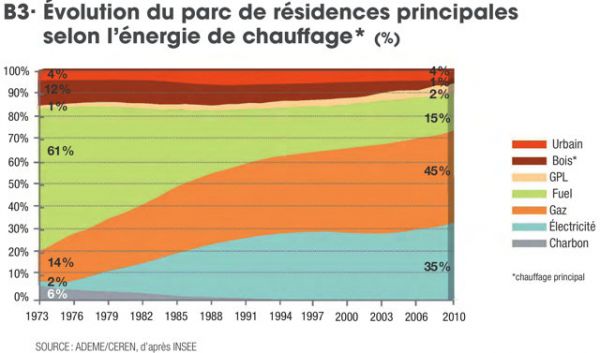

. On se doute que s'il s'agit de ne pas pouvoir regarder le match de foot sur son écran plat, le client risque de ne pas être convaincu par l'amélioration. Il faut donc disposer de consommation qu'on peut déplacer et actuellement, il s'agit essentiellement du ... chauffage électrique. Ce point est d'ailleurs parfois pris en compte par certains scénarios "100% renouvelables". C'est aussi l'idée qui fonde le tarif heures pleines - heures creuses en France. On note toutefois une certaine différence entre les désirs des promoteurs du consommer mieux et la réalité que semble devoir impliquer le concept. Étant donné l'opposition au chauffage électrique dans certains milieux politiques et la faisabilité du reste, il me semble que cette idée de vendre des services supplémentaires soit vouée à rester d'une ampleur limitée.

Si on veut une concurrence dans le domaine de l'énergie, la question des prix de production — donc des moyens — semble donc incontournable.

La vexante question des prix et des coûts de production

Lorsqu'on se tourne vers la question de la production, on s'aperçoit qu'en fait, sur ce sujet, il n'y a jamais eu de monopole légal de la production tant de gaz que d'électricité. La seule production significative de gaz sur le territoire français a été le gaz de Lacq. La conséquence a été que dans le Sud-Ouest, le réseau de distribution de gaz est organisé autour de l'ancien gisement et toujours détenu par l'exploitant de celui-ci, Total, qui l'a hérité d'Elf. Ce gisement ne suffisant pas à satisfaire les besoins français, on a procédé à des importations. De toute façon, le gaz étant une énergie régionale et substituable au pétrole, les prix de la matière première sont déterminés sur les marchés internationaux. Et pour l'Europe, la tendance semble être à la hausse des prix. En effet, l'exploitation des gisements de la Mer du Nord décline, actuellement lentement, mais ce déclin s'accélèrera après 2020-2025. La Russie a déjà du mal à fournir toutes les quantités demandées. Faire venir du gaz par méthanier coûte relativement cher à cause du processus de liquéfaction qui est gourmand en énergie. Enfin, le gouvernement français a interdit — pour l'instant du moins — d'exploiter d'éventuels gisements de gaz de schiste. Face à cette contrainte sur les volumes à consommer, la demande ne faiblit pourtant pas, le gaz étant de plus en plus employé à la place du charbon pour produire de l'électricité car il pollue moins et s'adapte mieux au contexte réglementaire et politique européen. Le gaz est aussi de plus en plus demandé dans les pays d'Asie. Le prix de l'énergie étant un sujet majeur de la politique, les différents gouvernements s'acharnent à ignorer ces réalités et cherchent à bloquer les prix, sans égards pour les conséquences. Dans ce contexte, on voit mal comment pourrait se développer la concurrence: l'ancien monopole est forcé de proposer des tarifs inférieurs aux prix qu'imposeraient les marchés internationaux. Pourquoi quitter le fournisseur qui propose les prix les plus bas et sera le dernier à augmenter ses tarifs?

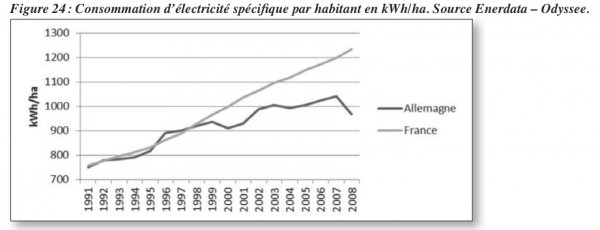

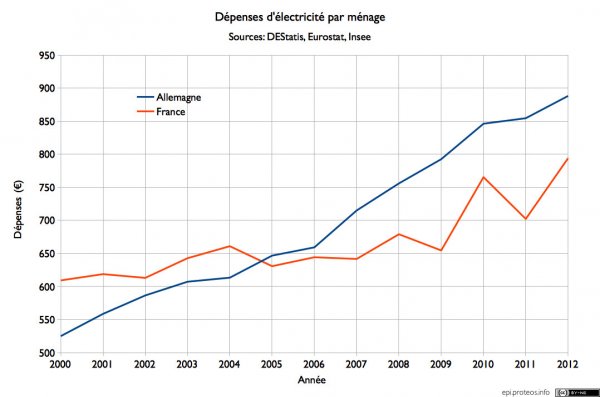

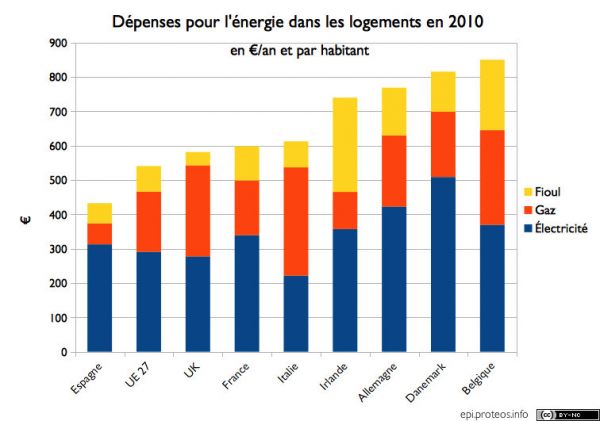

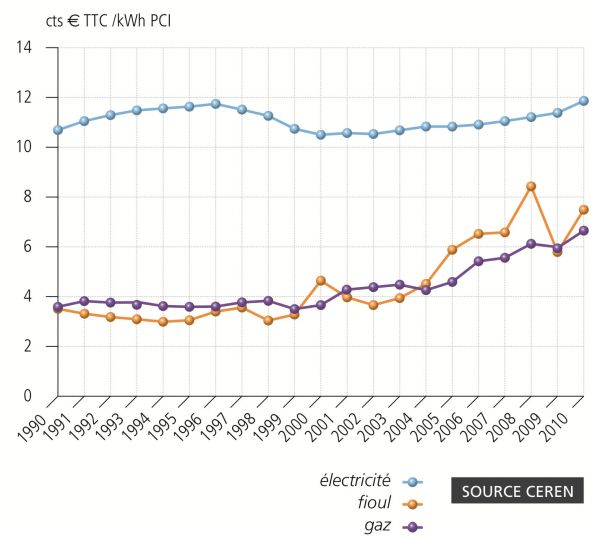

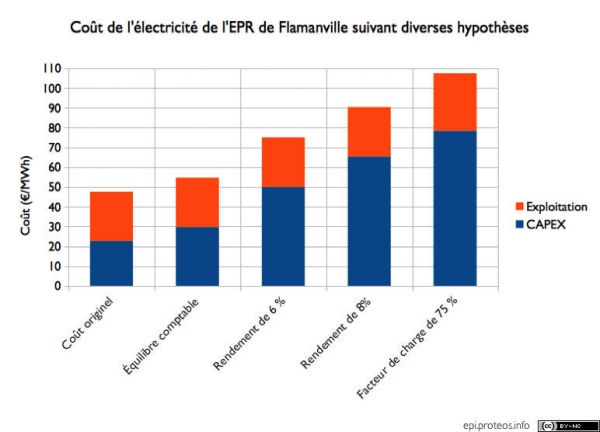

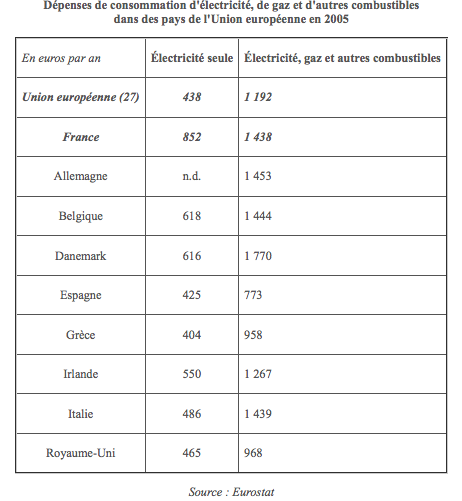

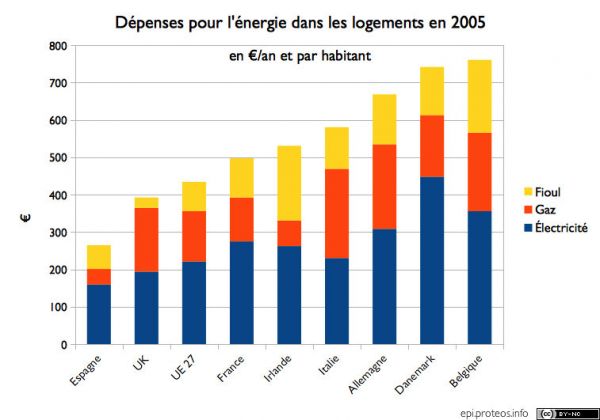

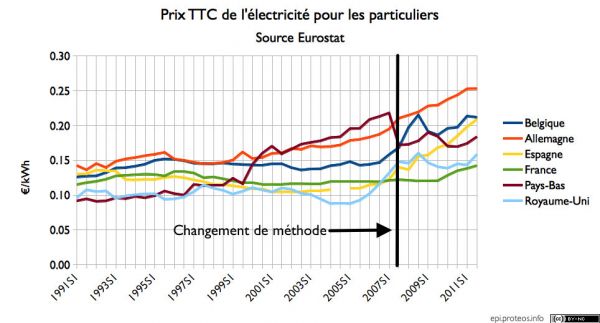

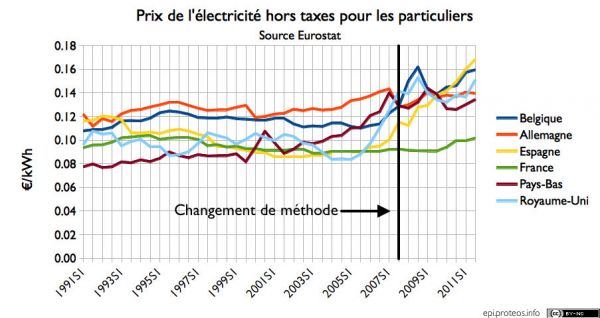

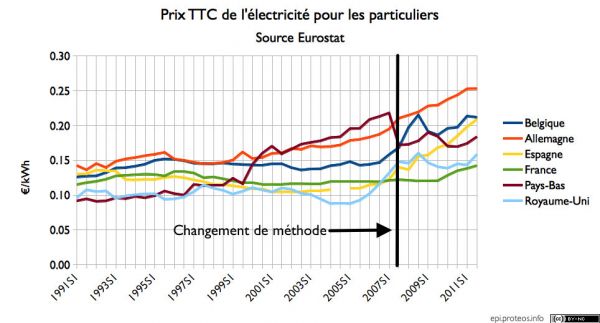

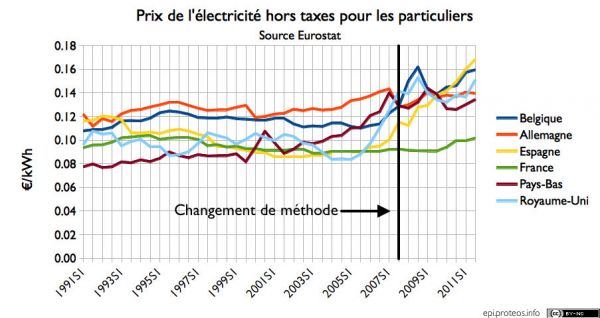

Pour ce qui est de l'électricité, de même, il n'y a jamais eu de monopole de production. L'exemple le plus frappant est celui de la Compagnie Nationale du Rhône qui a échappé à la nationalisation après la Libération. Ainsi en est-il aussi d'autres barrages. Reste qu'EDF pouvait connecter les centrales un peu comme bon lui semblait, mais avec l'ouverture à la concurrence, les risques de discrimination ont disparu. Aujourd'hui, le problème vient qu'à peu près tous les moyens neufs de production ont un coût moyen du kWh produit supérieur aux prix du marché: personne n'a donc vraiment envie d'en construire sans subvention, ou qui conduit ceux qui s'y sont risqués à la faillite. Ce problème est amplifié en France par l'importance du parc nucléaire: comme le prix de l'électricité nucléaire ne dépend que marginalement du prix du minerai, les prix de vente aux particuliers, fixés par l'état, ont faiblement varié par rapport à d'autres pays comme le montrent les graphes ci-dessous.

Les prix hors taxes reflètent le plus fidèlement les prix du parc déjà installé au début des années 2000: on voit qu'EDF échappe à la hausse généralisée à partir de 2005 du fait de sa faible dépendance aux combustibles fossiles. Comme c'était rappelé dans l'article du Monde, les autres producteurs ne peuvent pas rivaliser avec le parc nucléaire. Ce n'est pas seulement dû à l'amortissement du parc, mais aussi au fait que tous les concurrents commenceraient par construire des centrales demandant des investissements moindres: difficile pour un nouvel arrivant de dépenser plusieurs milliards d'euros avant de se constituer une clientèle.

Les prix hors taxes reflètent le plus fidèlement les prix du parc déjà installé au début des années 2000: on voit qu'EDF échappe à la hausse généralisée à partir de 2005 du fait de sa faible dépendance aux combustibles fossiles. Comme c'était rappelé dans l'article du Monde, les autres producteurs ne peuvent pas rivaliser avec le parc nucléaire. Ce n'est pas seulement dû à l'amortissement du parc, mais aussi au fait que tous les concurrents commenceraient par construire des centrales demandant des investissements moindres: difficile pour un nouvel arrivant de dépenser plusieurs milliards d'euros avant de se constituer une clientèle.

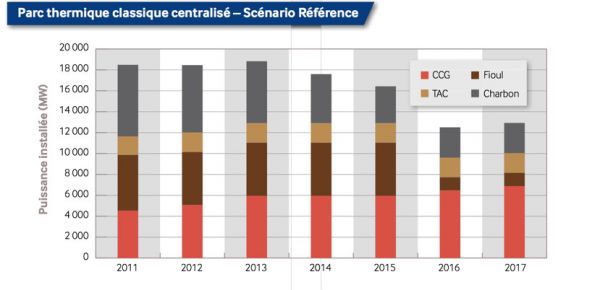

Cette importance des investissements dans l'industrie électrique se retrouve aussi dans le modèle imposé par la Commission. Pour empêcher que le monopole en place n'interdise l'entrée de concurrents, elle a poussé pour que la facturation de la production d'électricité se fasse en fonction du prix spot et a entravé les contrats à long terme. Dans le cas contraire, il aurait suffi à EDF de faire signer des contrats à long terme aux industriels pour enlever tout espoir de développement à la concurrence. De ce fait, pour minimiser les risques, le mode de production privilégié sera celui qui nécessitera le moins de nouveaux investissements et dont le coût marginal sera donc proche du coût total. Cela permet de passer assez facilement les hausses de tarifs aux clients — puisque le coût marginal se reflète dans le prix spot — et d'éviter les risques de pertes en capital. Cet état de fait est très bien expliqué dans ce papier de William Nuttal. Le seul point qui peut perturber cet attrait du gaz est qu'il y a besoin d'une corrélation entre le prix du gaz et de l'électricité, qui a tendance à disparaître lorsque le parc nucléaire est important. Une autre conséquence de la libéralisation est la faible planification pour remplacer les moyens de production existant et leur utilisation maximale: investir représente un risque conséquent et un coût à faire assumer par les clients. Et après de longues années, quand vient le temps de remplacer de vieilles centrales, par peur du black out, on voit le gouvernement anglais changer quelque peu de position.

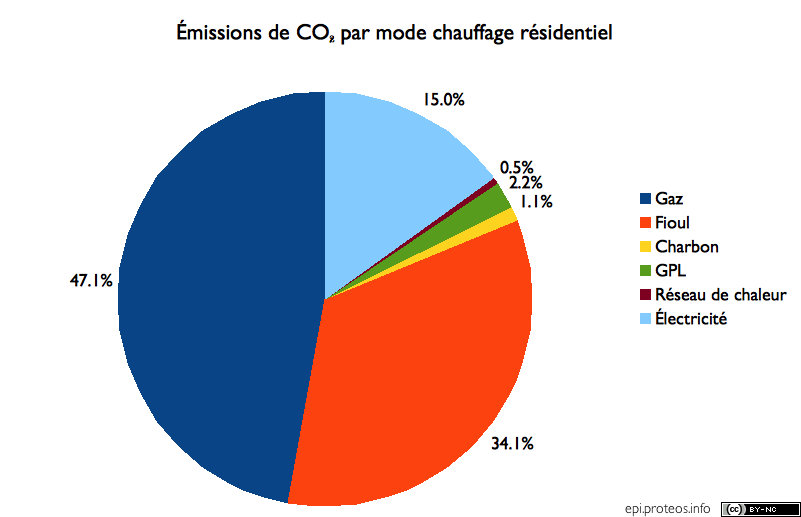

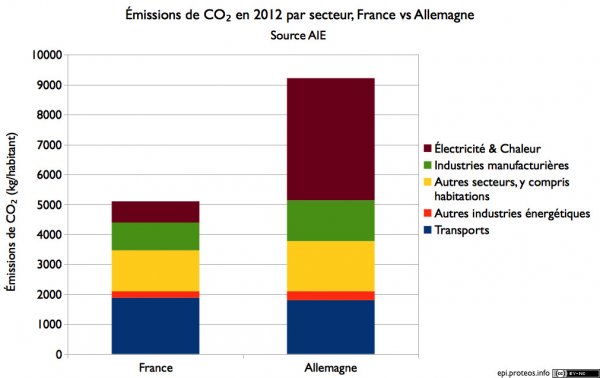

À la suite du contre-choc pétrolier et la mise en exploitation du gaz de la Mer du Nord, le gaz est devenu très compétitif au Royaume-Uni, d'autant que les sources locales de charbon se sont taries. Tant ce prix intéressant que les faibles besoins en investissements ont fait que le Royaume-Uni tire aujourd'hui presque 50% de son électricité de turbines à gaz à la suite de la libéralisation du secteur de l'électricité. À la fin des années 90 et du début des années 2000, les spécialistes du gaz expliquaient que les CCGTs étaient la moins chère des façons de produire de l'électricité, ce qu'on peut voir sur les graphes de prix: les pays spécialisés dans le gaz ont les prix HT les plus bas au début des années 2000. On comprend bien alors le bénéfice que voyait la Commission à libéraliser le secteur: on pouvait voir là une source de baisse de prix. Depuis, les choses ont quelque peu changé et, même s'il en émet moins que le charbon à énergie égale, les émissions de CO₂ dues à la combustion du gaz le rendent indésirable à terme. Le méchant monopole EDF a donc vu le choix du nucléaire dans les années 70 payer de nouveau quand sont réapparues, après 2005, des circonstances similaires au choc pétrolier ayant présidé à ce choix.

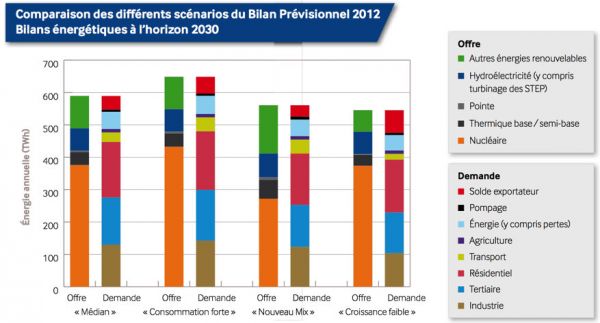

En plus de cela, les prix TTC montrent que l'action des états n'est pas neutre non plus: certains états affichent une forte différence entre les prix HT et TTC, notamment l'Allemagne. On aura reconnu les pays qui se sont lancé dans une politique de productions renouvelables. Comme elles sont fort chères et que leurs production ne sont pas corrélées à la demande et très intermittentes, personne ne les construirait sans subventions. Le mode de subvention choisi est la vente à un prix garanti. Aucune concurrence n'est donc possible: tous les producteurs vendent à ce prix garanti, l'état lève la même taxe sur tous les particuliers quelque soient les fournisseurs finaux. Ces modes de production partagent avec le nucléaire le fait d'être des industries à coûts fixes qui se prêtent très bien aux contrats à long terme ou aux tarifs régulés, des modes de rémunération plutôt centrés sur le coût moyen que le coût marginal. Et c'est pourquoi, en Allemagne, des voix se font entendre pour que les règles changent et que la Commission change de position sur la question de la tarification pour favoriser les renouvelables.

Quelques conclusions

Le projet de libéralisation de l'énergie reposait au fond sur une situation de fait qui a depuis changé: le faible prix des combustibles fossiles et notamment du gaz. Mais comme l'approvisionnement en gaz se fait plus incertain et que les préoccupations climatiques occupent, au moins officiellement, le devant de la scène, l'intérêt est devenu clairement douteux. À ce moment, dans les années 90, la technologie de la turbine à gaz semblait devoir s'imposer définitivement et elle est très adaptée à un marché libéralisé: faible investissement, coût dirigé par le prix du combustible.

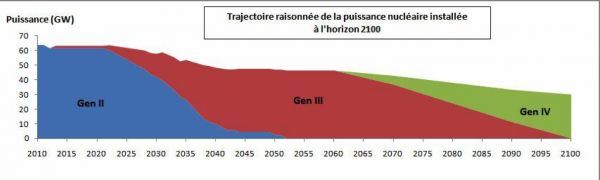

Malheureusement, le fait que le prix de l'énergie soit un sujet récurrent du débat public empêche, au moins en France, de suivre les soubresauts du prix du gaz imposés par les marchés financiers. Aucun concurrent ne peut s'implanter: l'ancien monopole est forcé de mener une politique de prix bas, voire de vendre à perte en période de forte hausse. Pour ce qui est de l'électricité, on comprend bien que dès lors que le nucléaire, et surtout les centrales de Génération II déjà construites, devient extrêmement compétitif, seuls les moyens subventionnés sont construits. On voit donc mal sur quoi se jouerait la concurrence et on voit même des industriels demander à payer pour assurer l'avenir du nucléaire et se protéger contre la prévisible hausse des prix. Autrement dit, les évolutions du prix des combustibles fossiles ont fait redevenir la production d'électricité ce qu'elle fut dans les années 70: une activité qui ressemble énormément à un monopole naturel.

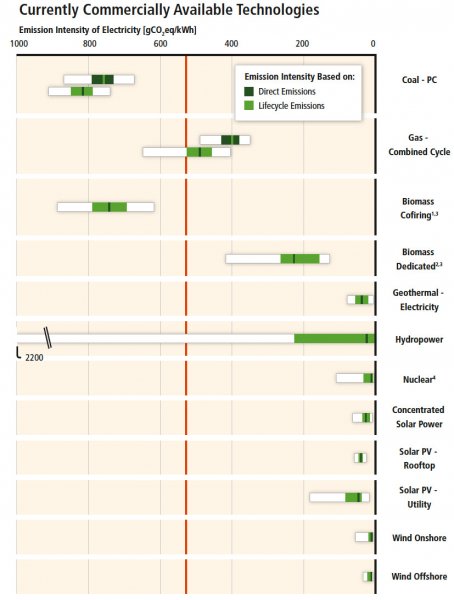

On constate que le nucléaire est parmi les moins émetteurs: la médiane des études le met à égalité ou presque avec l'éolien. On est donc bien en peine de trouver le moyen de production d'électricité qui produirait vraiment moins de CO₂ par unité d'énergie, ce qui est quand même l'essentiel pour lutter contre le réchauffement climatique. Le solaire phovoltaïque, par exemple, émet plus que le nucléaire, ce qui ne l'empêche pas d'être apprécié par les opposants au nucléaire. C'est à peine si l'auteur de l'article mentionne cela, tout au plus il mentionne que le GIEC classe le nucléaire parmi les sources

On constate que le nucléaire est parmi les moins émetteurs: la médiane des études le met à égalité ou presque avec l'éolien. On est donc bien en peine de trouver le moyen de production d'électricité qui produirait vraiment moins de CO₂ par unité d'énergie, ce qui est quand même l'essentiel pour lutter contre le réchauffement climatique. Le solaire phovoltaïque, par exemple, émet plus que le nucléaire, ce qui ne l'empêche pas d'être apprécié par les opposants au nucléaire. C'est à peine si l'auteur de l'article mentionne cela, tout au plus il mentionne que le GIEC classe le nucléaire parmi les sources