En décembre dernier, EDF a annoncé que l'EPR en construction actuellement à Flamanville coûterait encore plus cher que précédemment estimé, avec un coût prévu de 8G€ (en euros de 2007) soit environ 8.5G€ en euros de 2012 (c'est-à-dire en prenant en compte l'inflation). Cette annonce a suscité une révision des estimations de coûts du courant produit, comme celle de Bernard Laponche, de Global Chance, qui donne une fourchette de 100 à 120€/MWh. Cette estimation sert depuis au Monde de référence à confronter aux déclarations des politiques.

Cependant, ce genre de calculs est notoirement dépendant des hypothèses prises. Souvent ces estimations se servent de conventions, qui ne sont pas forcément réalisées ou qui mènent à des conséquences surprenantes. À partir du rapport de la Cour des Comptes de l'an dernier, on peut essayer de se faire une idée de ce que recouvrent ces estimations.

Les coûts d'exploitation

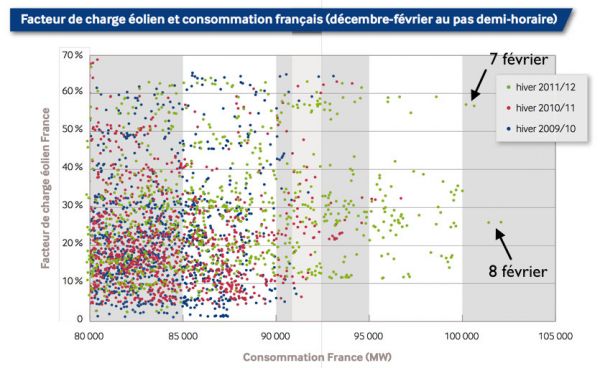

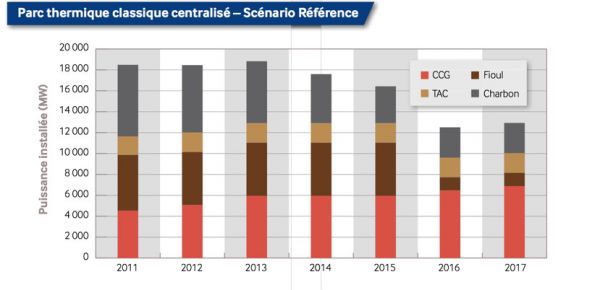

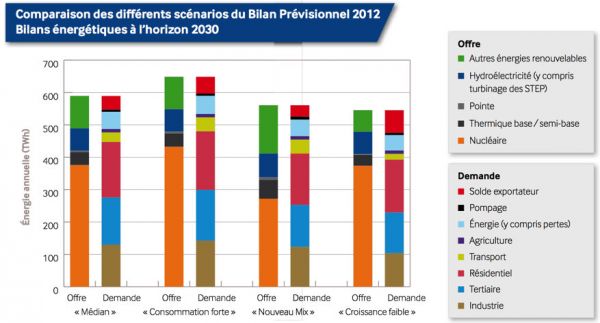

Dans son rapport, la Cour donne un coût d'exploitation du parc actuel de 22€/MWh (p55), hors démantèlement, stockage des déchets et avec une facture d'assurance très faible grâce au cadre légal actuel. L'EPR est censé avoir un meilleur rendement thermodynamique que le parc actuel, cela ferait gagner 0.5€/MWh produit. Le facteur de charge — le rapport entre la production réelle et le maximum possible dans l'année — est aussi annoncé à 90% comme meilleur que pour la moyenne du parc français — environ 75% — et plus proche des standards internationaux. Ce genre de performance est réalisée à l'étranger sur des réacteurs plus anciens et le meilleur rendement permettra à l'EPR d'être pratiquement tout le temps en tête de l'ordre de mérite du parc thermique: il y a donc de bonnes chances que le facteur de charge soit bien de 90%. Ce qui devrait entraîner une baisse de 15% de tous les autres coûts, soit environ 2.5€/MWh produit.

Le nouveau réacteur permettra sans doute aussi des économies sur le personnel, en diminuant le nombre de personnes requises. Cependant, il est difficile de se faire une idée sur les achats à l'extérieur pour assurer la maintenance. On est par contre à peu près sûr que les coûts des fonctions centrales et des impôts seront les mêmes en termes absolus. D'un autre côté, EDF envisage la mise en place de personnels et de moyens devant intervenir en cas d'accident nucléaire, ce qui ne sera pas gratuit. Pour fixer les idées, prendre l'hypothèse que les coûts baisseraient au total de 3€/MWh produit doit donner un ordre de grandeur correct.

Pour ce qui est du démantèlement, EDF a fait établir des devis qui donnent un coût d'environ 300€/kW (p110), le site de la NRC donne des montants de l'ordre de 400M€ pour des réacteurs de 900MW. On peut donc prévoir que le démantèlement devrait coûter quelque chose entre 500M€ et 1G€. Comme le réacteur est prévu pour produire environ 750TWh, l'ordre de grandeur du coût de démantèlement est de 1€/MWh. Les Cour chiffre le coût du retraitement et du stockage des déchets à environ 2€/MWh (p272). Au doigt mouillé, j'estime qu'une assurance du risque nucléaire coûterait 1€/MWh si les plafonds de responsabilité étaient réévalués.

La Cour donne aussi le montant des investissements de maintenance pour le parc actuel: 1.7G€ soit environ 4€/MWh. Ce montant était promis à une forte augmentation, les centrales devant être rénovées pour les amener à 60 ans de service, elles doivent aussi subir des travaux visant à améliorer leur sûreté suite à l'accident de Fukushima. Cependant, la décennie 2000 a été l'occasion de profiter d'un parc en bon état et de limiter ces investissements. Sur la durée de vie de l'EPR, je vais prendre une valeur de 2€/MWh, car la centrale est prévue pour 60 ans, il y aura donc sans doute moins de dépenses de maintenance et de rénovation; c'est cependant une estimation très grossière. Cela dit, au total, les coûts d'exploitation doivent tourner autour de 25€/MWh.

La rémunération du capital

De la même façon qu'un salarié ne vient pas travailler sans salaire, il est difficile d'attirer des investisseurs sans leur promettre qu'ils vont gagner de l'argent. C'est pourquoi il faut aussi compter une rémunération du capital dans le coût de toute production. Il est particulièrement important dans le cas d'industries capitalistiques comme le nucléaire.

Avant d'aborder la question du niveau de la rémunération, il existe plusieurs techniques pour estimer la rémunération du capital. On peut résonner par analogie avec des instruments financiers existant par ailleurs. La première façon est de considérer l'investissement comme une obligation remboursable in fine. Dans ce cas, il faut amortir linéairement l'investissement et verser des intérêts constants au cours de la durée de vie de l'installation. C'est un mode de calcul qui permet de calculer le prix minimal du courant qui va assurer l'équilibre comptable. Pour arriver à l'équilibre comptable, le capital ne doit rien rapporter — ce qui n'est pas vraiment une incitation à investir — et la dette être remboursée intérêts inclus.

Pour calculer le coût de l'électricité du parc nucléaire actuel en tenant compte d'une rémunération — strictement positive — du capital, la Cour des Comptes considère l'investissement réalisé comme un emprunt immobilier. Un emprunt immobilier consiste à verser des annuités constantes, dont une partie chaque année va au remboursement du capital. Ce capital remboursé ne porte plus intérêts et chaque année, la proportion de capital remboursé augmente dans l'annuité versée. Si on calcule l'annuité en fonction du capital investi et du taux d'intérêt, on se rend compte qu'il y a une équivalence avec une notion souvent utilisée en finance, la valeur actuelle nette. La valeur actuelle du flux de trésorerie que représente les intérêts annuels escomptés au taux d'intérêt payé est égale au capital investi au départ.

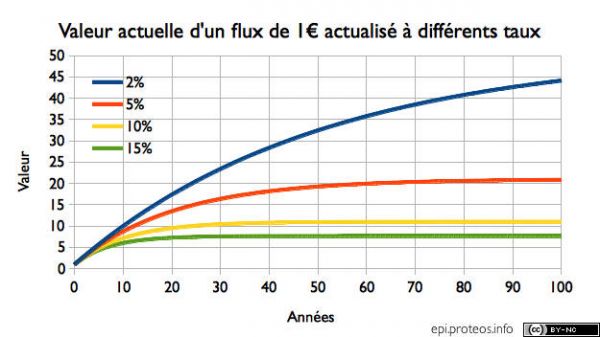

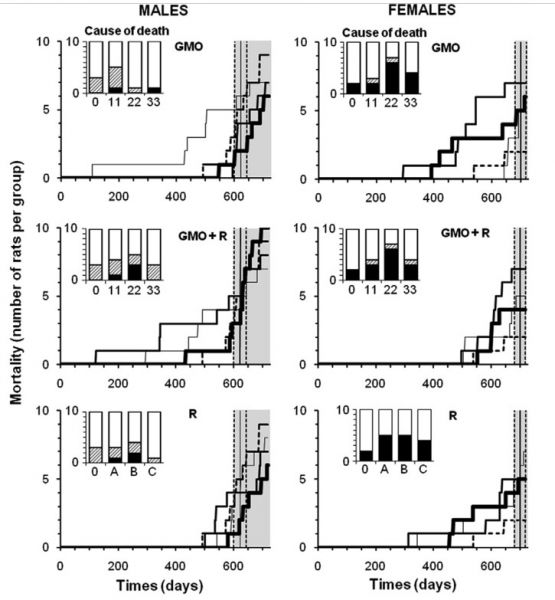

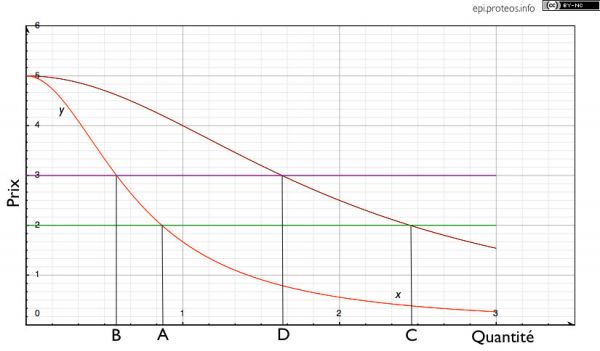

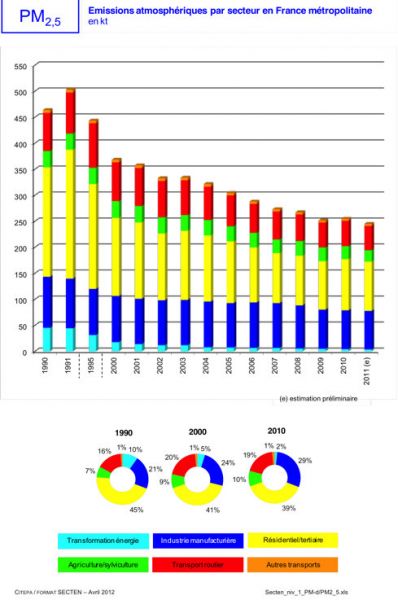

Cette remarque est importante car la valeur actuelle a quelques propriétés bien connues. Elle a des implications en termes de décision: seuls les projets ayant une valeur actuelle nette positive devraient être poursuivis. Ensuite, plus le taux d'intérêt est élevé, plus la vision est à court terme: à cause de la décroissance exponentielle en fonction du temps, le futur éloigné compte pour des clopinettes, comme on peut le voir sur le graphe ci-dessous. C'est d'ailleurs à court terme que la rémunération du capital a lieu dans un emprunt immobilier ... puisque le capital est surtout remboursé à la fin. Ce qui veut aussi dire que même si la durée de vie est de 60 ans, l'industriel peut se décider juste en ayant des assurances raisonnables sur les 10 à 20 ans qui viennent. Mais c'est aussi pour ça que dans les projets industriels, les sociétés sont obligées réglementairement de prévoir un fonds permettant de démolir l'usine, sans cela, aucun besoin de se préoccuper de ce qu'elle devient au moment de la construction.

Par ailleurs, la construction prend du temps, il faut prendre en compte le fait que le capital investit dort en partie. Il faut donc prendre en compte des coûts de ce fait, ce qui augmente le capital réellement investi au delà des 8.5G€ donnés par EDF. Pour mes calculs, je considère que le capital est investi par annuités constantes au cours de la construction.

Quel coût du capital?

Le capital peut être classé en 2 formes classiques: la dette et les capitaux propres. La dette se caractérise par le fait que la rémunération est fixée à l'avance par contrat, le créancier a alors une certaine assurance de ce qu'il va gagner. Les capitaux propres appartiennent aux actionnaires qui ne se voient pas promettre de rémunération particulière. On comprend donc qu'avant d'investir, les actionnaires voudront être mieux rémunérés pour assumer un risque supplémentaire. L'EPR est un exemple du genre de risques que peuvent avoir à assumer les actionnaires: hausse du coût des investissements, du coût d'exploitation, retard du chantier, prix de vente de la production plus bas que prévu, etc.

Pour estimer le coût de l'électricité, il faut donc considérer le coût moyen du capital. Dans son rapport, la Cour des Comptes prend le taux moyen qu'EDF utilise sans trop se prononcer sur sa validité (cf p338 du rapport). Il est de 7.8% hors inflation, soit un taux facial de presque 10%. La Cour trouve par contre qu'appliquer ce taux aux intérêts intercalaires est excessif et applique alors un taux de 4.5% réel. Cela peut s'expliquer par le fait que la construction ne recouvre qu'une partie des risques du projet, que la rémunération du capital couvre déjà en partie les risques de retard et de dépassement de budget, et que si une entreprise s'engage dans un projet capitalistique, c'est qu'il n'y en a peut-être aucun autre qui ait un rendement équivalent. En passant, la Cour ne répond pas à la question de savoir quelle a été le rendement réel de la construction du parc nucléaire actuel, ce qui a quand même une certaine importance.

Si on regarde les comptes d'EDF, on voit que sa dette est d'environ 40G€ et ses capitaux propres de 35G€ (p4 de cette saine lecture). On peut constater que les capitaux employés par EDF sont composés à moitié de dette et à moitié de capitaux propres, même si des variations autour de cette répartition sont constatées. EDF nous dit aussi que le taux moyen facial sur sa dette est de 4.1%. Ce qui veut dire que le taux pris par la Cour des Comptes mène à un rendement des capitaux propres de 16%. C'est tout de même beaucoup pour une entreprise en situation de monopole de fait et à l'activité régulée. C'est pourquoi en plus de la valeur Cour des Comptes, prendre des valeurs inférieures pour la rémunération du capital peut donner une image des coûts plus proche des conditions de financement réelles.

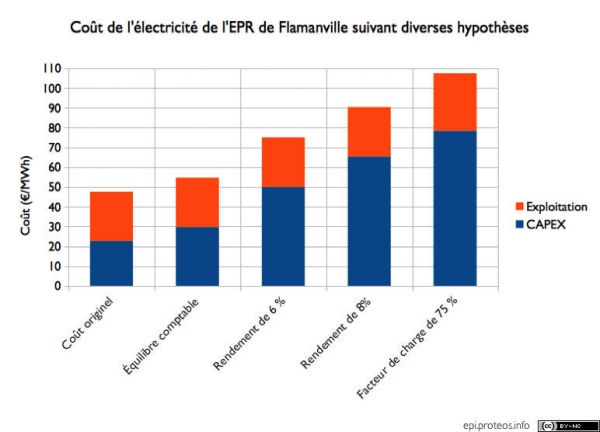

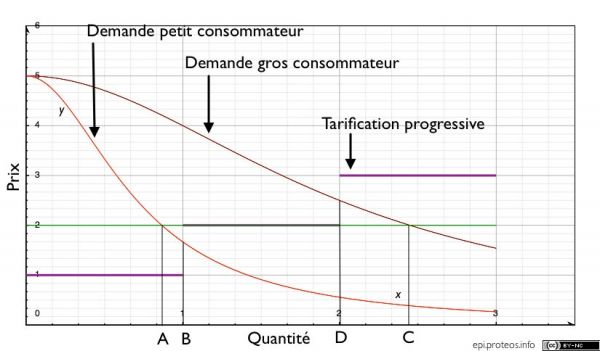

J'ai donc calculé les coûts associés à différentes hypothèses:

- Le coût donné à l'origine. L'EPR fut donné comme coûtant 3.3G€. Le calcul est fait pour un coût du capital de 8%, une construction de 4 ans — contre 4 ans et demi prévus initialement, facteur de charge de 90%. Aujourd'hui Areva affirme que l'EPR de série coûterait 60€/MWh. Avec ces hypothèses, cela conduit à un coût d'un réacteur de 5G€, relativement cohérent avec le coût de 10G£ prévus au Royaume-Uni pour la construction de 2 nouveaux réacteurs.

- Le prix du courant nécessaire pour arriver à l'équilibre comptable. Contrairement aux autres calculs, ce prix n'est pas à réévaluer tous les ans de l'inflation. On peut constater qu'EDF va certainement perdre de l'argent avec un EPR à 8.5G€. L'électricité vaut en effet actuellement environ 50€/MWh pour une production permanente.

- Le rendement de 6% donne le coût si on considère que le coût moyen du capital est de 6% en sus de l'inflation au lieu des 8% pris par la Cour des Comptes. Cela correspond à une rémunération des fonds propres de 12%, plus raisonnable à mon sens.

- Le rendement de 8% reprend le calcul de la Cour des Comptes avec le coût du capital donné par EDF.

- Le dernier calcul donne le coût avec un facteur de charge abaissé à 75% comme pour le parc actuel. Cela fait aussi remonter le coût d'exploitation.

quelques conclusions

Il est à peu près certain qu'EDF va réaliser une perte comptable avec l'EPR de Flamanville. En prenant les hypothèses de la Cour des Comptes sur le rendement du capital, je trouve un coût compris entre 90 et 110€/MWh suivant le facteur de charge. Si un coût moyen du capital plus faible est choisi, le coût de l'électricité baisse assez rapidement. Il est aussi assez remarquable que les opposants principaux à cette nouvelle centrale endossent des demandes élevées de rentabilité du capital et une approche financière court-termiste, contrairement à ce que leur discours laisse penser par ailleurs.

Derniers commentaires