Le 1er mars dernier, la Cour des Comptes a publié un référé pour faire des remontrances au gouvernement sur la question des taxes sur les carburants. En effet, le gouvernement n'inclut pas dans la liste des dépenses fiscales l'exonération du kérosène pour les avions, la fiscalité avantageuse du diésel ainsi que celle du charbon. Elle remarquait finement que taxer le diésel consommé par les particuliers comme le sans-plomb rapporterait presque 7G€ par an et faisait une allusion tout aussi fine au fameux chiffre de 42000 morts par an dus au diésel en France. Comme l'idée d'aligner la fiscalité du diésel sur celle du sans-plomb semble planer avec insistance, cela a amené le retour vengeur du diésel qui tue dans la presse. Comme je m'étais fendu d'un billet l'an dernier sur le sujet lors de la dernière poussée de fièvre sur le sujet, je me suis donc moi aussi décidé à faire un retour vengeur et à l'actualiser — entre autres à l'aide de ce billet-là — pour bien montrer qu'il n'y a absolument aucune chance pour que le diésel puisse causer 42000 décès chaque année en France.

Comme ce billet s'annonce long et que ton temps, ô lecteur, est certainement précieux, voici un résumé de ce qui va suivre.

Il n'y a aucune chance pour que le diésel soit la cause de 42000 morts par an en France pour les raisons suivantes:

- Ce chiffre était donné à l'origine pour l'ensemble des émissions de particules de moins de 2.5µm (PM2.5). Le diésel ne représente que 10% de ces émissions.

- Ce chiffre est calculé sur la base des émissions en l'an 2000. Depuis, les émissions ont baissé d'un tiers.

- Cette étude a eu une suite dont les conclusions conduisent, via une extrapolation linéaire très incorrecte, à pratiquement 3 fois moins de morts.

- Ce chiffre n'a pas la signification qu'on soit capable de relier les pics de pollutions aux morts. Il s'agit d'une donnée mathématique abstraite, qui est mieux exprimée en perte d'espérance de vie.

- Pour ce qui est de la liaison directe entre niveau de pollution et mortalité, on se risquera à une évaluation à la louche qui est d'environ 5000 morts pour l'ensemble de la pollution aux particules et de 1000 morts pour le diésel. J'estime même maintenant que c'est une évaluation maximale en ce qui concerne le diésel.

On s'essaiera ensuite à une exégèse de la communication gouvernementale sur le sujet dont il va ressortir qu'il s'attaque au sujet de la fiscalité du diésel par la face de la santé publique par opportunisme et manque d'autres choix. Il s'est en effet fermé diverses portes par ses déclarations précédentes. Ce qui n'est guère étonnant vue l'incompétence dont il a fait preuve jusqu'ici, incompétence largement due au manque de travail sérieux sur les questions énergétiques lorsque le PS était dans l'opposition — ce qui est, accessoirement, un thème récurrent sur ce blog.

Pourquoi le diésel ne peut tout se prendre sur le dos

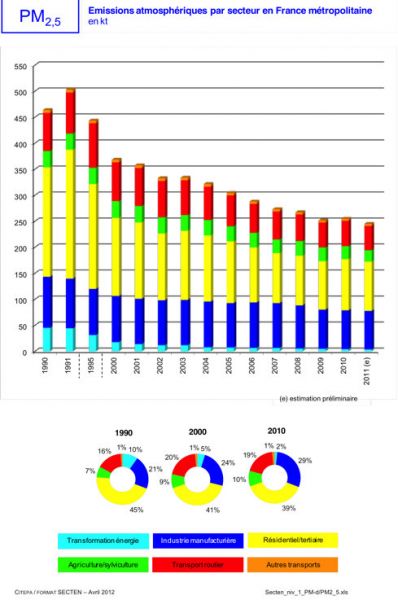

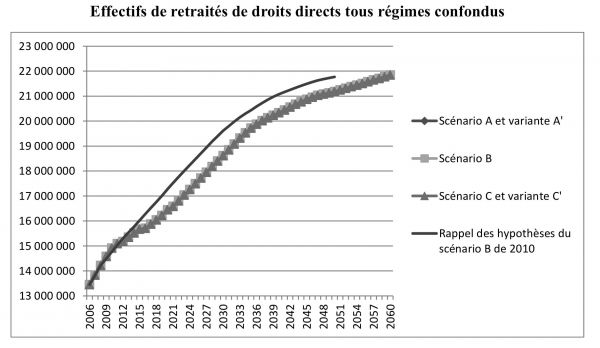

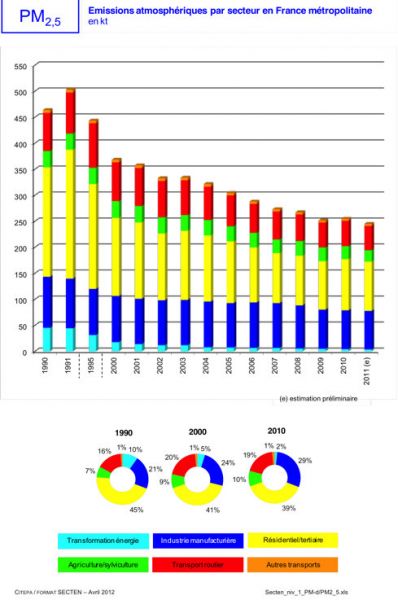

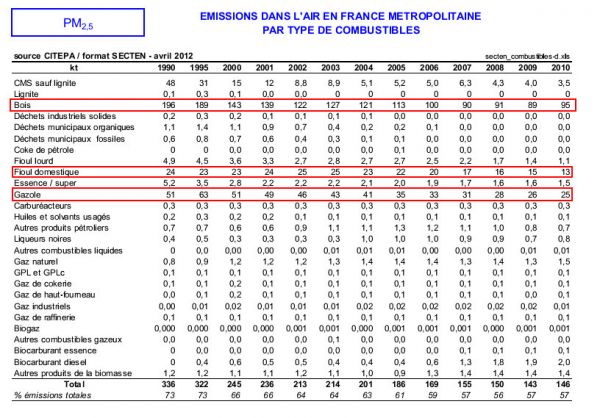

Commençons par le début: le chiffre de 42000 morts est donné sur le site du ministère de l'environnement comme valable pour l'ensemble de la pollution aux PM2.5. On nous donne aussi la source, le programme CAFE, on y revient plus loin. Pour l'instant, une évidence s'impose: le diésel n'est peut-être pas le seul émetteur de PM2.5. S'il était responsable de la majeure partie des émissions, on pourrait presque tout lui mettre sur le dos; au contraire, s'il n'est qu'un émetteur marginal, c'est gonflé. De plus, le programme CAFE se base sur les émissions de l'an 2000, il faudrait donc tenir compte de l'évolution de la situation puisque ce billet est rédigé en 2013. Par chance, la France dispose d'un organisme qui recense et évalue toutes sortes de pollutions atmosphériques, dont les PM2.5, le CITEPA. Il publie chaque année un rapport qui les compile. On peut alors en tirer cette figure (p90)

On peut voir sur ce graphe que les émissions ont baissé d'un tiers entre 2000 et 2011. Le modèle menant au chiffre honni étant linéaire, le nombre de morts devrait déjà être ajusté d'autant. Mais il y a mieux: on voit distinctement que le transport routier ne compte que pour 19% des émissions totales. Rien qu'avec ça, je peux affirmer qu'il est strictement impossible que le diésel tue 42000 personnes par an en France. Si on continue la lecture de ce précieux tome, on tombe p224 sur un superbe tableau qui détaille les émissions par combustible.

On peut voir sur ce graphe que les émissions ont baissé d'un tiers entre 2000 et 2011. Le modèle menant au chiffre honni étant linéaire, le nombre de morts devrait déjà être ajusté d'autant. Mais il y a mieux: on voit distinctement que le transport routier ne compte que pour 19% des émissions totales. Rien qu'avec ça, je peux affirmer qu'il est strictement impossible que le diésel tue 42000 personnes par an en France. Si on continue la lecture de ce précieux tome, on tombe p224 sur un superbe tableau qui détaille les émissions par combustible.

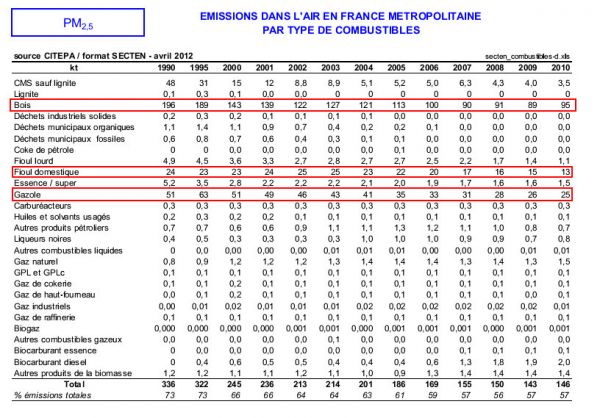

On y voit que le diésel seul représente 25kt, contre 250kt de PM2.5 émises chaque année. Le biodiésel n'ajoute que 2kt. Dit simplement, le diésel ne représente que 10% des émissions totales de PM2.5. Le reste des émissions du secteur des transports est dû marginalement à l'essence, de façon plus importante à des choses comme l'usure des pneus. Mettre sur le dos du diésel l'ensemble des morts est donc sérieusement gonflé.

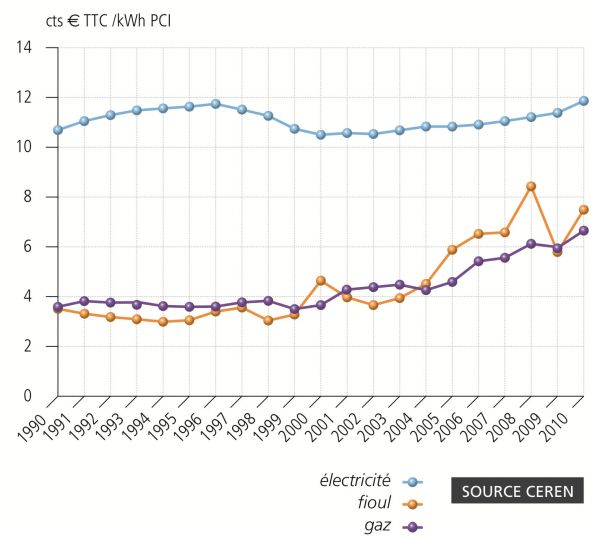

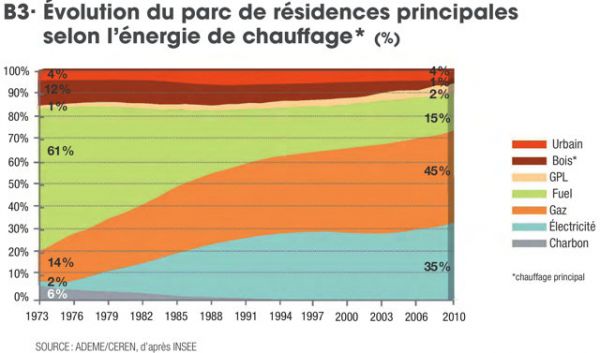

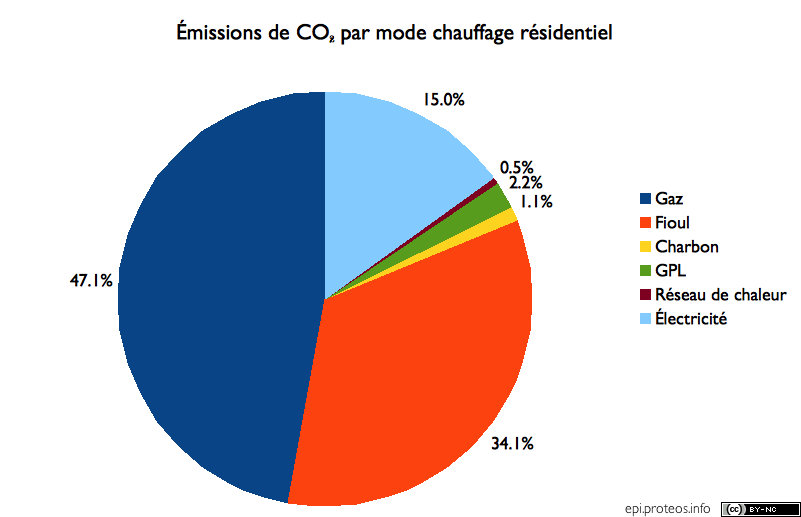

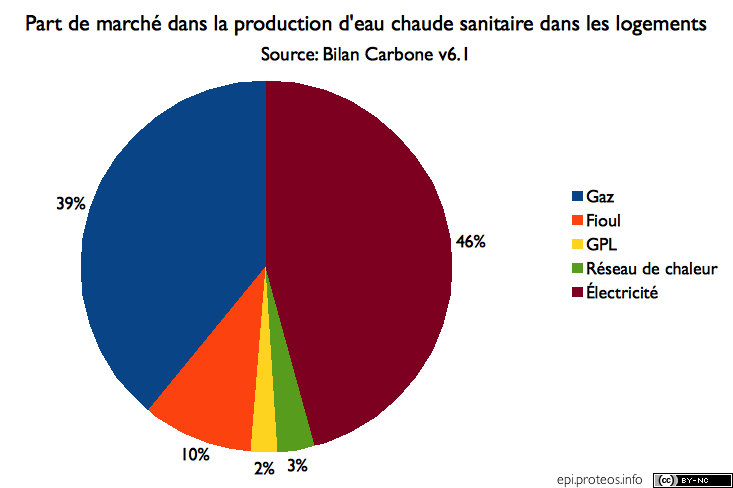

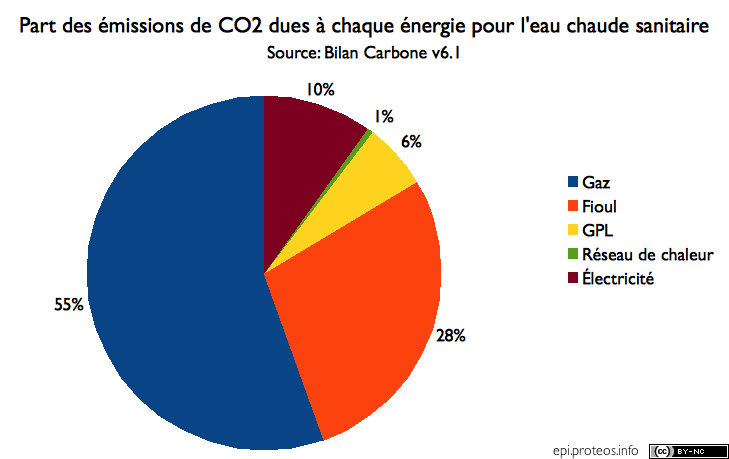

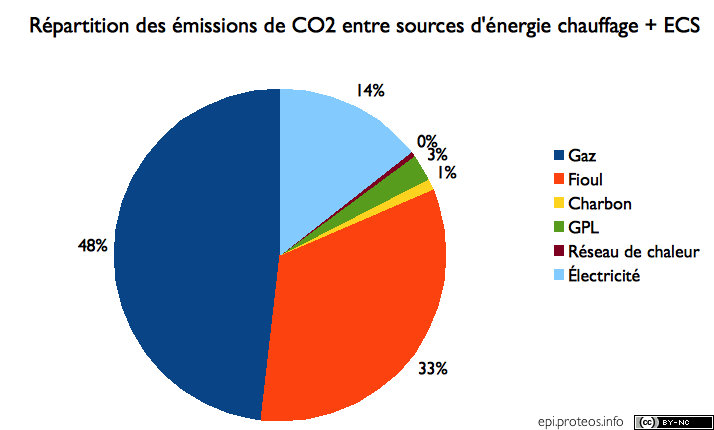

On constate aussi une particularité des émissions de PM2.5: les premiers émetteurs sont liés au chauffage des locaux avec 39% des émissions liés aux secteurs résidentiel et tertiaire. Le tableau détaillant par combustible nous dénonce 2 autres coupables: le fioul domestique et ... le bois qui émet à lui tout seul quasiment 4 fois plus de PM2.5 que le diésel, concentrés lors des mois froids de l'année.

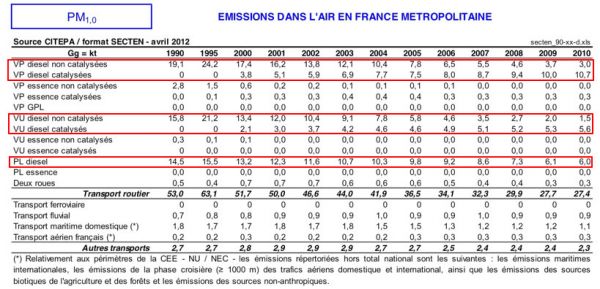

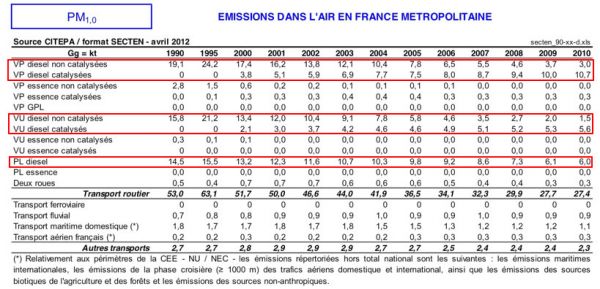

Mais ce n'est pas tout. Si on se limite aux particules de moins de 1µm, on se limite en fait aux émissions dues au combustible utilisé et on élimine les émissions dues à l'usure. On constate (tableau p205) que les poids lourds émettent 6kt sur 27. Il est laissé à la sagacité du lecteur de savoir si les poids lourds seront concernés par une éventuelle hausse des taxes sur le diésel. Il ne semble pas non plus qu'on empêche les poids lourds de rouler au diésel dans un avenir proche.

Bref: une éventuelle hausse des taxes sur le diésel ne concernerait que 8% des émissions de PM2.5.

Bref: une éventuelle hausse des taxes sur le diésel ne concernerait que 8% des émissions de PM2.5.

D'où sortent ces 42000 morts?

L'autre point frappant, c'est que 42k morts représentent une part importante de la mortalité en France, c'est presque 8% des décès constatés chaque année. Pour fixer les idées, on estime qu'il y a 60k décès liés au tabagisme et qu'il cause 80% des décès par cancer du poumon. Comme les effets du tabagisme et des particules ne doivent pas être bien différents, il y a un problème de concurrence entre ces deux causes: il n'y a pas assez de morts de maladies respiratoires ou cardiaques pour qu'il n'y ait pas de recouvrement entre causes. Dit autrement, si on additionnait tous les morts qu'on lie à une cause quelconque en France, on aboutirait à une somme supérieure au nombre total de décès annuels en France. D'une certaine façon, il y a des gens qu'il faut tuer plusieurs fois avant qu'ils ne soient définitivement répertoriés comme morts.

En l'occurrence, ce chiffre sort à l'origine d'un programme européen, CAFE. Le chiffre de 42000 figure dans ce fichier excel à la ligne «morts prématurées». Les conclusions de ce programme ont fait par la suite l'objet d'un document de l'OMS. Une lecture cursive du fichier excel ainsi que du document de l'OMS montre d'ailleurs une caractéristique bizarre: il y a plus de morts — 350k/an au niveau de l'Europe — que d'admissions à l'hôpital — 100k/an — pour la même cause (pXII du document de l'OMS). Si ces morts étaient conformes à l'idée naïve qu'on peut s'en faire, ce serait l'inverse: aux dernières nouvelles, on ne laisse pas les gens mourir chez eux sans rien tenter en Europe de l'Ouest. Surtout quand il s'agit de gens qui ont des problèmes respiratoires et vont certainement demander de l'aide. Il est remarquable que ce «détail» n'ait pas eu l'air d'alerter grand monde sur la signification de ce chiffre.

Le programme CAFE a consisté à modéliser la présence de PM2.5 sur l'Europe pour en déduire un certain nombre de conséquences sur la santé à long terme. On a découpé l'Europe en cases, où on pouvait assigner une concentration moyenne en PM2.5 et la population y vivant. À partir de là, le nombre de morts y est calculé en prenant la concentration en PM2.5 (exprimée en µg/m³) et la multipliant par le taux de 0.6% par µg/m³ ainsi que le nombre de décès dans une case. Ce qui revient à dire qu'il y a à long terme un excès de mortalité de 0.6% par µg/m³ de PM2.5. Tout ceci est expliqué dans la notice méthodologique (p57). Il y est dit que cette méthode est ... fausse et qu'elle surévalue notoirement le nombre de morts. Mais qu'elle est utilisée parce qu'elle est facile à mettre en œuvre et rend un résultat facile à comprendre

ou, autrement dit, pour des raisons publicitaires. À la page suivante, il nous est clairement dit que la méthode préférée est de compter en termes d'années d'espérance de vie perdues, surtout que la méthode est destinée à faire des évaluations de politiques, menées ou à mener, en fonction de la valeur d'une année d'espérance de vie. La vraie question à laquelle le programme CAFE voulait répondre, c'est de savoir de combien de temps la mort est-elle hâtée, en moyenne, par la faute des particules.

L'autre biais est celui du double comptage: sauf erreur de ma part, il n'y a aucun contrôle pour des comportements individuels comme le tabagisme. Ça favorise aussi l'emploi d'un modèle linéaire. Imaginons que la population soit divisée en 2 catégories, les non-fumeurs, pour qui il existe un seuil en deçà duquel les particules n'ont pas d'effet, et les fumeurs, pour qui toute concentration de PM2.5 hâte des décès parce que le seuil est dépassé à cause du tabagisme. Dans ce cas, toute concentration de PM2.5 va hâter des décès pour l'ensemble de la population puisqu'on aura un mélange indiscernable de fumeurs et de non-fumeurs. À long terme, si un fumeur meurt d'une affection respiratoire, et que les particules n'ont d'effet que sur eux, dira-t-on qu'il est mort du tabac ou des particules? On peut aussi constater que, dans ce cas, la meilleure façon de lutter contre la mortalité par les particules peut devenir … la lutte contre le tabagisme. Un biais supplémentaire est l'effet mémoire: les niveaux de pollution aux particules ont fortement baissé depuis les années 70s, mais nombre de ceux en vie à cette époque sont toujours vivants aujourd'hui. Ces études à long terme observent donc en partie les effets de la pollution du temps jadis. Les émissions de particules ont été divisées par 2 depuis 1990, et l'usage du charbon — autre émetteur de particules historiquement important en Europe et très actuel en Chine — a fortement diminué depuis les années 70s et les centrales à charbon ou au fioul dotées de filtres. Et on peut donc dire que le nombre de morts annoncés n'a rien à voir et est nettement plus élevé que ce qu'on entend généralement par mort à cause de...

.

De plus un autre programme a succédé à CAFE, Aphekom. Les résultats du programme en ce qui concerne la France ont été chroniqués ailleurs: cette fois-ci, en étudiant des agglomérations rassemblant 12M d'habitants, on ne trouve que 2900 décès attribuables, pour les niveaux de pollution de 2004 à 2006. À la différence de CAFE, ce programme considère qu'il y a un seuil à 10µg/m³ et attribue la diminution de l'espérance de vie à la partie de la concentration dépassant ce seuil. Pour Paris, le site d'Airparif nous dit que ça correspond à une perte de 6 mois. On peut aussi voir que, d'un programme à l'autre l'évaluation, si on l'extrapole violemment par une règle de 3 à l'ensemble de la population française, est passée à 15000 morts. Sans que ceux-ci soient tellement plus rattachables à leur cause que les morts du programme CAFE.

Pour relier directement les effets des particules aux morts, il y a les études à court terme qui lient les hospitalisations et les décès aux pics de pollution pour voir quelle est la variation et en tirer une relation entre concentration de polluants et morts. Un autre document de l'OMS nous donne la relation à court terme (p257): une augmentation des décès de 0.6% tous les 10µg/m³, un facteur 10 de moins que les effets à long terme. On trouve donc à la louche un ordre de grandeur de 5000 décès directement imputables aux particules par an en France dont seulement 1000 maximum peuvent à la rigueur être imputés au diésel, mais plus probablement 500, puisque le diésel ne compte que pour 10% des émissions.

Pourquoi le gouvernement utilise-t-il cet argument?

On peut maintenant se tourner sur les raisons pour lesquelles le gouvernement utilise l'argument de la santé publique pour vouloir pousser une hausse des taxes sur le diésel et les aligner sur celles de l'essence. La première raison, c'est qu'ils croient sincèrement que le diésel fait des morts tous les ans en France. Sans doute pas 42000, sans quoi on aurait des réactions plus violentes comme la recherche d'une interdiction pure et simple des rejets de particules. C'est la politique qui a été menée avec le durcissement constant des normes portant non seulement sur les moteurs d'automobiles, mais aussi sur les installations industrielles comme les centrales au charbon. Aujourd'hui, les filtres à particules des véhicules diésel filtreraient plus de 99% des particules (source: communication de l'Académie de médecine, p3-4). Le problème pourrait donc se régler de lui-même au fur et à mesure du renouvèlement du parc, quitte à le lier à un durcissement du contrôle technique.

Comme on l'a noté plus haut, le bois et le fioul domestique constituent aussi une source importante de PM2.5, puisque le bois représente à lui seul 4 fois les émissions de PM2.5 du diésel. À ce sujet, il me souvient d'avoir entendu, dans la même interview de 10 minutes, l'inénarrable Jean-Vincent Placé fustiger le diésel pour ses émissions de particules et porter au pinacle le chauffage au bois. On le voit, il y a une certaine dichotomie entre la réalité de la pollution aux particules et sa représentation dans le discours public. Toutefois, on s'aperçoit que les feux de cheminée sont aussi dans le collimateur en région parisienne. Dans l'article du Parisien, on pouvait lire la réaction appropriée d'une vice-présidente Verte du conseil régional:

« Il n’est pas question de créer une police des feux de cheminée, mais d’alerter tous ceux qui utilisent ce moyen de chauffage sans connaître son impact », réagit Hélène Gassin, vice-présidente (EELV) du conseil régional d’Ile-de-France. « Mais, prévient-elle, il ne faudrait pas se focaliser sur la chasse aux foyers ouverts et laisser les particules de bois cacher la forêt du diesel. »

Au total, il ne me semble pas que les propositions de taxation du diésel pour cause de particules soient particulièrement crédibles dans ces conditions! Les politiques deviendront crédibles sur ce sujet lorsqu'ils proposeront une taxe sur le bois — très probable en cette époque.

Les raisons du retour de l'idée d'aligner les fiscalités de l'essence et du diésel sont donc en partie à chercher ailleurs. Par exemple, Jérôme Cahuzac disait lundi dernier qu'il faudrait trouver 6G€ l'année prochaine, une somme très proche des 7G€ que rapporterait l'alignement des fiscalités. Je constate aussi que les taxes sur le carburants sont presque les seules à n'avoir pas été augmentées dans ce cycle d'austérité. D'autre part, la France entend réduire sa consommation de pétrole, à la fois pour des raisons géopolitiques — le peak oil — et climatiques — puisque la combustion du diésel dégage fatalement du CO₂. Pour cela, il faudra sans doute augmenter de façon conséquente la fiscalité des carburants.

Mais le gouvernement ne peut le dire directement: on a eu droit à un épisode qui a conduit à baisser temporairement les mêmes taxes cet été. Le gouvernement y a été poussé car il s'est fait fort de stopper la hausse du prix des carburants lors de la dernière campagne électorale. Et ce, alors même que les problèmes climatiques et d'approvisionnement pétrolier sont connus depuis longtemps. Le gouvernement s'est donc lié les mains et ne peut plus justifier une hausse des taxes sur les carburants par le besoin de financement de l'état, les problèmes climatiques ou d'approvisionnement. Il ne peut donc plus qu'utiliser des moyens détournés pour arriver à ses fins. La mise en cause du diésel sur le plan sanitaire semble donc représenter une bonne occasion pour enfin réaliser cet objectif. Car enfin, cet objectif d'alignement des fiscalités est légitime: le diésel ne présente aucun avantage sanitaire par rapport à l'essence, émet la même masse de CO₂ par litre brûlé, la différence de consommation étant désormais couverte par le système de bonus-malus. Tout devrait pousser à cet alignement. Mais faute de l'avoir dit dans la campagne électorale voire avant, le gouvernement en est réduit à chercher une issue de secours. Cette voie n'est pas sans danger, car une fois qu'on a mis en cause les effets sanitaires du diésel aujourd'hui, on risque des réactions épidermiques complètement déconnectées de la dangerosité réelle du carburant.

Finalement, tout cela a un air de déjà vu: ces contorsions sont du même tonneau que celle qui entouraient la tarification progressive de l'énergie. Comme on n'avait pas bossé le sujet dans l'opposition ni eu la sincérité d'exposer la situation telle qu'elle est, on s'est fermé la voie vers des solutions intelligentes.

Derniers commentaires